Une nouvelle IA dessine des images ravissantes et moins ravissantes

Vous avez peut-être vu récemment des images étranges et fantaisistes sur Internet. Il y a un chien Shiba Inu portant un béret et un col roulé noir. Et une loutre de mer dans le style de la jeune fille à la perle du peintre hollandais Vermeer. Et un bol de soupe qui ressemble à un monstre tricoté en laine.

Ces images n’ont pas été dessinées par un illustrateur humain. Au lieu de cela, ils ont été créés par DALL-E 2, un nouveau système d’IA capable de transformer des descriptions textuelles en images. Écrivez simplement ce que vous voulez voir, et l’IA le dessine pour vous avec des détails saisissants, une haute résolution et, sans doute, une réelle créativité.

Sam Altman, le PDG d’OpenAI, la société qui a créé DALL-E 2, l’a qualifié de la chose la plus agréable à jouer avec laquelle nous ayons créé jusqu’à présent et amusante d’une manière que je n’ai pas ressentie de la technologie depuis un moment.

C’est tout à fait vrai : DALL-E 2 est délicieux et amusant! Mais comme beaucoup de choses amusantes, c’est aussi très risqué.

Il y a des risques évidents que les gens puissent utiliser ce type d’IA pour tout faire, de la pornographie aux deepfakes politiques, ou la possibilité que cela finisse par mettre certains illustrateurs humains au chômage. Mais il y a aussi le risque que DALL-E 2, comme tant d’autres systèmes d’IA de pointe, renforce les stéréotypes et les préjugés nuisibles et, ce faisant, accentue certains de nos problèmes sociaux.

Comment DALL-E 2 renforce les stéréotypes et que faire à ce sujet

Comme c’est généralement le cas pour les systèmes d’IA, DALL-E 2 a hérité des biais du corpus de données utilisé pour l’entraîner : des millions d’images récupérées sur Internet et leurs légendes correspondantes. Cela signifie que pour toutes les images délicieuses produites par DALL-E 2, il est également capable de générer de nombreuses images qui sont ne pas délicieux.

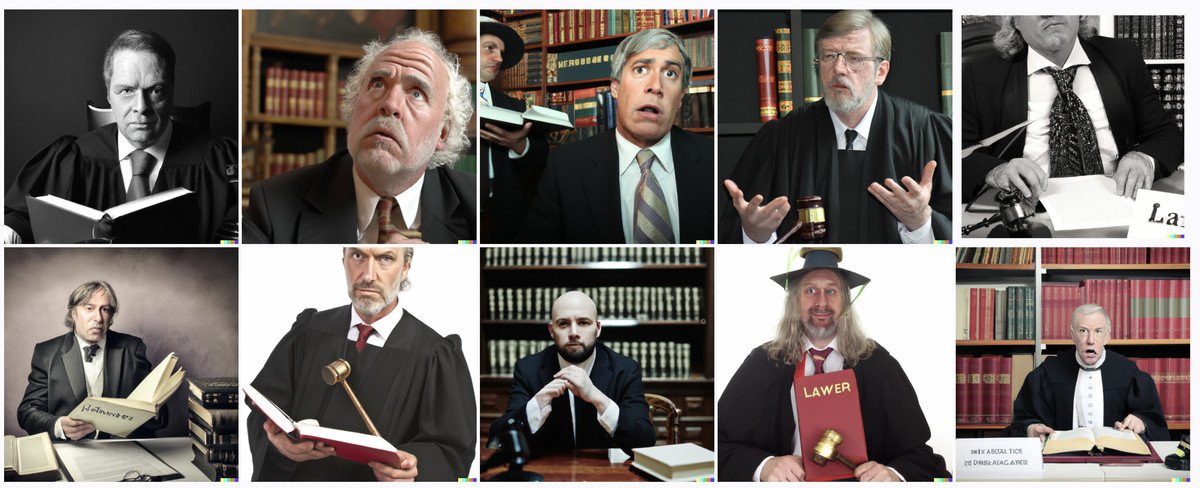

Par exemple, voici ce que l’IA vous donne si vous lui demandez une image d’avocats :

En attendant, voici la sortie de l’IA lorsque vous demandez un agent de bord :

OpenAI est bien conscient que DALL-E 2 génère des résultats présentant des préjugés sexistes et raciaux. En fait, les exemples ci-dessus proviennent du document Risques et limitations de l’entreprise, que vous trouverez si vous faites défiler vers le bas de la page Web principale du DALL-E 2.

Les chercheurs d’OpenAI ont fait quelques tentatives pour résoudre les problèmes de biais et d’équité. Mais ils ne pouvaient pas vraiment éliminer ces problèmes de manière efficace car différentes solutions entraînent différents compromis.

Par exemple, les chercheurs voulaient filtrer le contenu sexuel des données de formation car cela pourrait entraîner un préjudice disproportionné pour les femmes. Mais ils ont constaté que lorsqu’ils essayaient de filtrer cela, DALL-E 2 générait moins d’images de femmes en général. Ce n’est pas bon, car cela conduit à un autre type de préjudice pour les femmes : l’effacement.

OpenAI est loin d’être la seule société d’intelligence artificielle à faire face à des problèmes de biais et à des compromis. C’est un défi pour toute la communauté de l’IA.

Le biais est un énorme problème à l’échelle de l’industrie auquel personne n’a de réponse efficace et infaillible, m’a dit Miles Brundage, responsable de la recherche sur les politiques chez OpenAI. Donc, une grande partie du travail en ce moment consiste simplement à être transparent et franc avec les utilisateurs sur les limitations restantes.

Pourquoi publier un modèle d’IA biaisé ?

En février, avant la sortie de DALL-E 2, OpenAI a invité 23 chercheurs externes à red team it engineering-speak pour essayer de trouver autant de failles et de vulnérabilités que possible, afin que le système puisse être amélioré. L’une des principales suggestions de l’équipe rouge était de limiter la version initiale aux seuls utilisateurs de confiance.

À son crédit, OpenAI a adopté cette suggestion. Pour l’instant, seules environ 400 personnes (un mélange d’employés et de membres du conseil d’administration d’OpenAIs, ainsi que d’universitaires et de créatifs triés sur le volet) peuvent utiliser DALL-E 2, et uniquement à des fins non commerciales.

C’est un changement par rapport à la façon dont OpenAI a choisi de déployer GPT-3, un générateur de texte salué pour son potentiel à améliorer notre créativité. Étant donné une phrase ou deux écrites par un humain, il peut ajouter plus de phrases qui ressemblent étrangement à des humains. Mais son parti pris à l’encontre de certains groupes, comme les musulmans, qu’il associe de manière disproportionnée à la violence et au terrorisme. OpenAI était au courant des problèmes de biais, mais a quand même communiqué le modèle à un groupe limité de développeurs et d’entreprises approuvés, qui pourraient utiliser GPT-3 à des fins commerciales.

L’année dernière, j’ai demandé à Sandhini Agarwal, chercheur au sein de l’équipe politique d’OpenAIs, s’il était logique que GPT-3 soit sondé par des chercheurs pour ses biais alors même qu’il était diffusé à certains acteurs commerciaux. Elle a dit qu’à l’avenir, c’est une bonne chose à laquelle nous devrions penser. Vous avez raison de dire que, jusqu’à présent, notre stratégie a été de faire en sorte que cela se produise en parallèle. Et peut-être que cela devrait changer pour les futurs modèles.

Le fait que l’approche de déploiement ait changé pour DALL-E 2 semble être une étape positive. Pourtant, comme le reconnaît le document DALL-E 2s Risks and Limitations, même si l’aperçu lui-même n’est pas directement nuisible, sa démonstration du potentiel de cette technologie pourrait motiver divers acteurs à accroître leurs investissements dans les technologies et tactiques connexes.

Et vous devez vous demander : cette accélération est-elle une bonne chose, à ce stade ? Voulons-nous vraiment construire et lancer ces modèles maintenant, sachant que cela peut inciter les autres à publier leurs versions encore plus rapidement ?

Certains experts affirment que, puisque nous savons qu’il y a des problèmes avec les modèles et que nous ne savons pas comment les résoudre, nous devrions donner à la recherche en éthique de l’IA le temps de rattraper les progrès et de résoudre certains des problèmes, avant de continuer à construire et à publier de nouvelles technologies. .

Helen Ngo, chercheuse affiliée au Stanford Institute for Human-Centered AI, dit que nous avons désespérément besoin de mesures standard pour les biais. Un peu de travail a été fait pour mesurer, par exemple, la probabilité que certains attributs soient associés à certains groupes. Mais c’est super sous-étudié, a déclaré Ngo. Nous n’avons pas encore vraiment établi de standards ou de normes de l’industrie sur la façon de mesurer ces problèmes, sans parler de les résoudre.

OpenAIs Brundage m’a dit que laisser un groupe limité d’utilisateurs jouer avec un modèle d’IA permet aux chercheurs d’en savoir plus sur les problèmes qui surgiraient dans le monde réel. Il y a beaucoup de choses que vous ne pouvez pas prévoir, il est donc précieux d’entrer en contact avec la réalité, a-t-il déclaré.

C’est assez vrai, mais puisque nous connaissons déjà de nombreux problèmes qui se posent à plusieurs reprises dans l’IA, il n’est pas clair que ce soit une justification suffisamment forte pour lancer le modèle maintenant, même de manière limitée.

Le problème des incitations mal alignées dans l’industrie de l’IA

Brundage a également noté une autre motivation chez OpenAI : la compétition. Certains des chercheurs en interne étaient ravis de diffuser cela dans le monde parce qu’ils voyaient que d’autres rattrapaient leur retard, a-t-il déclaré.

Cet esprit de compétition est une impulsion naturelle pour toute personne impliquée dans la création de technologies transformatrices. Il faut également s’y attendre dans toute organisation qui vise à réaliser un profit. Être le premier à sortir de la porte est récompensé, et ceux qui terminent deuxièmes sont rarement rappelés dans la Silicon Valley.

Comme l’a dit l’équipe d’Anthropic, une société de sécurité et de recherche sur l’IA, dans un article récent, les incitations économiques à construire de tels modèles, et les incitations de prestige à les annoncer, sont assez fortes.

Mais il est facile de voir comment ces incitations peuvent être mal alignées pour produire une IA qui profite vraiment à toute l’humanité. Plutôt que de supposer que d’autres acteurs créeront et déploieront inévitablement ces modèles, il est donc inutile d’attendre, nous devrions nous poser la question : comment pouvons-nous réellement changer la structure d’incitation sous-jacente qui anime tous les acteurs ?

L’équipe d’Anthropic propose plusieurs idées. L’une de leurs observations est qu’au cours des dernières années, une grande partie des recherches les plus éclatantes sur l’IA ont migré du milieu universitaire vers l’industrie. Pour mener des expériences d’IA à grande échelle de nos jours, vous avez besoin d’une tonne de puissance de calcul plus de 300 000 fois supérieure à celle dont vous aviez besoin il y a dix ans, ainsi que des meilleurs talents techniques. C’est à la fois cher et rare, et le coût qui en résulte est souvent prohibitif dans un cadre universitaire.

Une solution serait donc de donner plus de moyens aux chercheurs universitaires ; puisqu’ils n’ont pas d’incitation au profit pour déployer commercialement leurs modèles rapidement de la même manière que les chercheurs de l’industrie, ils peuvent servir de contrepoids. Plus précisément, les pays pourraient développer des nuages de recherche nationaux pour permettre aux universitaires d’accéder à une puissance de calcul gratuite, ou du moins bon marché; il en existe déjà un exemple à Calcul Canada, qui coordonne l’accès à de puissantes ressources informatiques pour les chercheurs canadiens.

L’équipe d’Anthropic recommande également d’explorer une réglementation qui modifierait les incitations. Pour ce faire, écrivent-ils, il y aura une combinaison de réglementation douce (par exemple, la création de meilleures pratiques volontaires par l’industrie, les universités, la société civile et le gouvernement) et une réglementation dure (par exemple, le transfert de ces meilleures pratiques dans les normes et la législation ).

Bien que certaines bonnes nouvelles normes aient été adoptées volontairement au sein de la communauté de l’IA ces dernières années, comme la publication de cartes modèles, qui documentent les risques d’un modèle, comme OpenAI l’a fait pour DALL-E 2, la communauté n’a pas encore créé de normes reproductibles qui indiquent clairement comment les développeurs doivent mesurer et atténuer ces risques.

Ce manque de normes rend à la fois plus difficile le déploiement de systèmes, car les développeurs peuvent avoir besoin de déterminer leurs propres politiques de déploiement, et cela rend également les déploiements intrinsèquement risqués, car il y a moins de connaissances partagées sur ce à quoi ressemblent les déploiements sûrs, écrit l’équipe Anthropic. Nous construisons en quelque sorte l’avion au fur et à mesure qu’il décolle.