Toutes ces images ont été générées par la dernière IA text-to-image de Google

Il y a une nouvelle tendance en vogue dans l’IA : les générateurs de texte en image. Donnez à ces programmes le texte que vous aimez et ils généreront des images remarquablement précises qui correspondent à cette description. Ils peuvent correspondre à une gamme de styles, des peintures à l’huile aux rendus CGI et même aux photographies, et bien que cela semble cliché à bien des égards, la seule limite est votre imagination.

À ce jour, le leader dans le domaine est DALL-E, un programme créé par le laboratoire d’IA commercial OpenAI (et mis à jour en avril dernier). Hier, cependant, Google a annoncé sa propre vision du genre, Imagen, et il vient de renverser DALL-E dans la qualité de sa sortie.

La meilleure façon de comprendre l’incroyable capacité de ces modèles est de simplement examiner certaines des images qu’ils peuvent générer. Il y en a quelques-uns générés par Imagen ci-dessus, et encore plus ci-dessous (vous pouvez voir plus d’exemples sur la page de destination dédiée de Google).

Dans chaque cas, le texte au bas de l’image était l’invite introduite dans le programme, et l’image ci-dessus, la sortie. Juste pour souligner: c’est tout ce qu’il faut. Vous tapez ce que vous voulez voir et le programme le génère. Assez fantastique, non?

Mais si ces images sont indéniablement impressionnantes par leur cohérence et leur précision, elles doivent également être prises avec des pincettes. Lorsque des équipes de recherche comme Google Brain publient un nouveau modèle d’IA, elles ont tendance à sélectionner les meilleurs résultats. Ainsi, bien que ces images aient toutes l’air parfaitement polies, elles peuvent ne pas représenter la sortie moyenne du système Image.

Souvent, les images générées par les modèles texte-image semblent inachevées, tachées ou floues. Problèmes que nous avons vus avec les images générées par le programme OpenAIs DALL-E. (Pour en savoir plus sur les points problématiques des systèmes texte-image, consultez ce fil Twitter intéressant qui plonge dans les problèmes avec DALL-E. Cela met en évidence, entre autres, la tendance du système à mal comprendre les invites et à lutter avec le texte et les visages.)

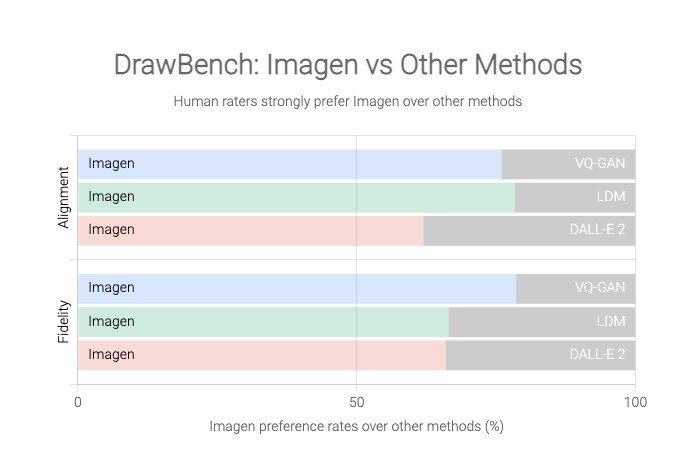

Google, cependant, affirme qu’Imagen produit des images toujours meilleures que DALL-E 2, sur la base d’un nouveau benchmark qu’il a créé pour ce projet nommé DrawBench.

DrawBench n’est pas une métrique particulièrement complexe : il s’agit essentiellement d’une liste de quelque 200 invites de texte que l’équipe de Google a introduites dans Imagen et d’autres générateurs de texte en image, la sortie de chaque programme étant ensuite jugée par des évaluateurs humains. Comme le montrent les graphiques ci-dessous, Google a constaté que les humains préféraient généralement la sortie d’Imagen à celle de leurs rivaux.

Il sera cependant difficile d’en juger par nous-mêmes, car Google ne met pas le modèle Imagen à la disposition du public. Il y a aussi une bonne raison à cela. Bien que les modèles texte-image aient certainement un potentiel créatif fantastique, ils ont également une gamme d’applications troublantes. Imaginez un système qui génère à peu près n’importe quelle image que vous aimez être utilisée pour de fausses nouvelles, des canulars ou du harcèlement, par exemple. Comme le note Google, ces systèmes codent également les préjugés sociaux et leur production est souvent raciste, sexiste ou toxique d’une autre manière inventive.

Cela est dû en grande partie à la façon dont ces systèmes sont programmés. Essentiellement, ils sont formés sur d’énormes quantités de données (dans ce cas : de nombreuses paires d’images et de légendes) qu’ils étudient pour les modèles et apprennent à reproduire. Mais ces modèles ont besoin de beaucoup de données, et la plupart des chercheurs, même ceux qui travaillent pour des géants de la technologie bien financés comme Google, ont décidé qu’il était trop onéreux de filtrer de manière exhaustive cette entrée. Ainsi, ils récupèrent d’énormes quantités de données sur le Web et, par conséquent, leurs modèles ingèrent (et apprennent à répliquer) toute la bile haineuse que vous vous attendez à trouver en ligne.

Comme les chercheurs de Google résument ce problème dans leur article : [T]Les besoins en données à grande échelle des modèles texte-image […] ont conduit les chercheurs à s’appuyer fortement sur de vastes ensembles de données, pour la plupart non conservés et récupérés sur le Web […] Les audits des ensembles de données ont révélé que ces ensembles de données ont tendance à refléter des stéréotypes sociaux, des points de vue oppressifs et des associations désobligeantes ou autrement nuisibles aux groupes identitaires marginalisés.

En d’autres termes, l’adage bien usé des informaticiens s’applique toujours dans le monde fulgurant de l’IA : ordures à l’intérieur, ordures à l’extérieur.

Google n’entre pas dans trop de détails sur le contenu troublant généré par Imagen, mais note que le modèle encode plusieurs préjugés et stéréotypes sociaux, y compris un biais général en faveur de la génération d’images de personnes à la peau plus claire et une tendance à aligner les images représentant différentes professions. avec les stéréotypes de genre occidentaux.

C’est quelque chose que les chercheurs ont également découvert lors de l’évaluation de DALL-E. Demandez à DALL-E de générer des images d’une hôtesse de l’air, par exemple, et presque tous les sujets seront des femmes. Demandez des photos d’un PDG et, surprise, surprise, vous obtenez un groupe d’hommes blancs.

Pour cette raison, OpenAI a également décidé de ne pas publier DALL-E publiquement, mais la société donne accès à certains bêta-testeurs. Il filtre également certaines entrées de texte afin d’empêcher que le modèle ne soit utilisé pour générer des images racistes, violentes ou pornographiques. Ces mesures limitent dans une certaine mesure les applications potentiellement nuisibles de cette technologie, mais l’histoire de l’IA nous dit que de tels modèles de conversion de texte en image deviendront presque certainement publics à un moment donné dans le futur, avec toutes les implications troublantes qu’un accès plus large apporte. .

La propre conclusion de Google est qu’Imagen n’est pas adapté à un usage public pour le moment, et la société déclare qu’elle prévoit de développer une nouvelle façon de comparer les préjugés sociaux et culturels dans les travaux futurs et de tester les futures itérations. Pour l’instant, cependant, il faut bien se contenter de la sélection optimiste d’images de la royauté des ratons laveurs et des cactus portant des lunettes de soleil. Ce n’est que la pointe de l’iceberg, cependant. L’iceberg fait des conséquences imprévues de la recherche technologique, si Imagen veut se lancer dans la génération ce.