Google AI présente Minerva : un modèle de traitement du langage naturel (TAL) qui résout des questions mathématiques

Les grands modèles de langage sont largement adoptés dans une gamme de tâches en langage naturel, telles que la réponse aux questions, le raisonnement de bon sens et la synthèse. Ces modèles, cependant, ont eu des difficultés avec des tâches nécessitant un raisonnement quantitatif, telles que la résolution de problèmes en mathématiques, en physique et en ingénierie.

Les chercheurs trouvent que le raisonnement quantitatif est une application intrigante pour les modèles linguistiques, car ils mettent les modèles linguistiques à l’épreuve de diverses manières. La capacité d’analyser avec précision une requête avec un langage normal et une notation mathématique, de se souvenir des formules et des constantes pertinentes et de produire des réponses étape par étape nécessitant des calculs numériques et une manipulation symbolique sont nécessaires pour résoudre des problèmes mathématiques et scientifiques. Par conséquent, les scientifiques pensent que les modèles d’apprentissage automatique nécessiteront des améliorations significatives de l’architecture des modèles et des méthodes de formation pour résoudre ces problèmes de raisonnement.

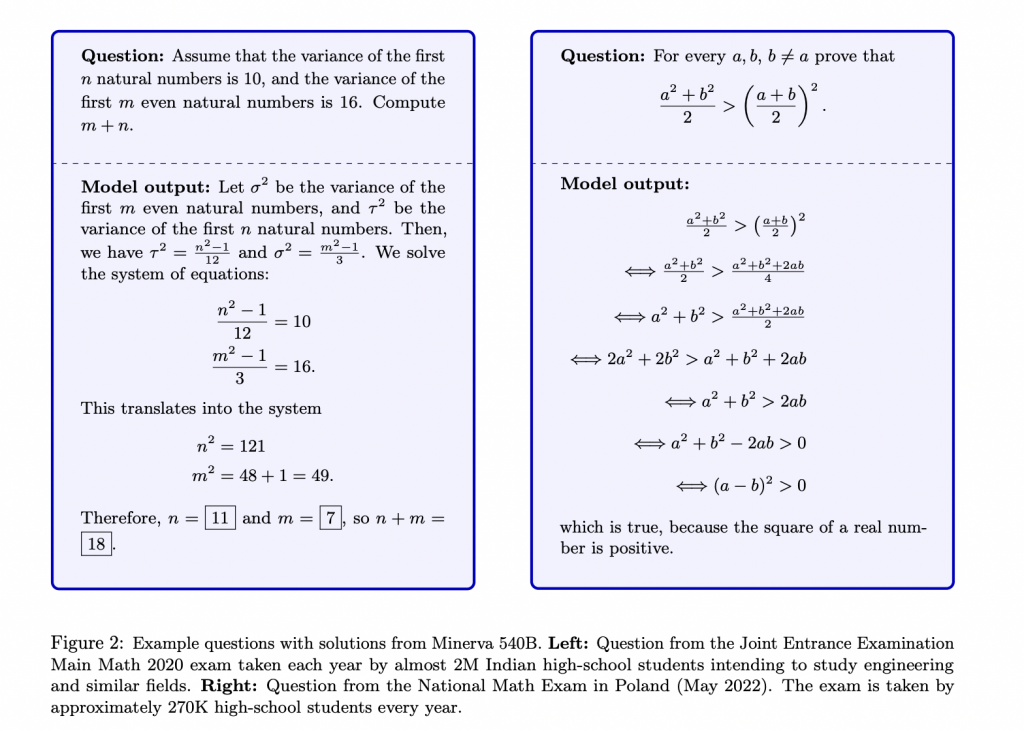

Une nouvelle recherche de Google présente Minerva, un modèle de langage qui utilise le raisonnement séquentiel pour répondre à des problèmes mathématiques et scientifiques. Minerva résout ces problèmes en fournissant des solutions incorporant des calculs numériques et des manipulations symboliques.

Leurs résultats démontrent que les performances sur une gamme de tâches de raisonnement quantitatif difficiles s’améliorent considérablement en se concentrant sur la collecte de données de formation pertinentes pour les défis de raisonnement quantitatif, la formation de modèles à grande échelle et l’utilisation des meilleures approches d’inférence.

Les chercheurs ont formé Minerva sur un ensemble de données de 118 Go d’articles scientifiques du service de préimpression arXiv et de pages Web avec des expressions mathématiques en LaTeX, MathJax ou d’autres formats. Le modèle maintient les symboles et les informations de formatage dans les données d’apprentissage comme étant cruciaux pour la signification sémantique des équations mathématiques. Cela permet au modèle de communiquer en utilisant la notation mathématique conventionnelle.

Afin de répondre plus efficacement aux problèmes mathématiques, Minerva utilise également des procédures d’incitation et de notation contemporaines. Ceux-ci incluent le vote à la majorité et la chaîne de pensée ou le bloc-notes. Comme la plupart des modèles de langage, Minerva donne des probabilités à plusieurs résultats potentiels. Il génère plusieurs réponses en échantillonnant de manière stochastique tous les résultats potentiels tout en répondant à une question. Bien que les étapes de ces méthodes soient différentes, elles conduisent souvent à la même conclusion. Minerva sélectionne ensuite la solution la plus fréquente comme réponse finale en utilisant le vote à la majorité.

Les chercheurs ont examiné Minerva sur des critères STEM allant des défis au niveau de l’école primaire aux cours de niveau universitaire testant ses compétences de raisonnement numérique. Ces repères comprenaient :

- Problèmes des concours de mathématiques du secondaire

- MMLU-STEM, un sous-ensemble du référentiel Massive Multitask Language Understanding axé sur les matières STEM aux niveaux secondaire et collégial, y compris l’ingénierie, la chimie, les mathématiques et la physique.

- GSM8k qui inclut les opérations arithmétiques de base utilisées dans les problèmes mathématiques des écoles primaires

- OCWCourses, un ensemble de défis de niveau collégial et universitaire du MIT OpenCourseWare qui englobent une gamme de sujets STEM tels que la chimie de l’état solide, l’astrophysique, les équations différentielles et la relativité restreinte.

Leurs conclusions montrent que Minerva produit constamment des résultats de pointe, parfois de manière significative.

Comme indiqué dans leur récent article, l’équipe souligne que leur stratégie de raisonnement quantitatif n’est pas basée sur les mathématiques formelles. Sans structure mathématique sous-jacente claire, Minerva analyse les requêtes et produit des réponses en utilisant une combinaison de langage naturel et d’expressions mathématiques LaTeX. Selon eux, l’incapacité de la méthode à vérifier automatiquement les réponses du modèle est un inconvénient important. Même lorsque le résultat final est connu et vérifiable, le modèle peut utiliser des processus de raisonnement erronés qui ne peuvent pas être automatiquement identifiés pour parvenir à la réponse finale.

Les modèles d’apprentissage automatique sont d’excellents outils dans de nombreux domaines scientifiques, mais ils ne sont souvent utilisés que pour résoudre des problèmes particuliers. L’équipe espère que leur modèle capable de raisonnement quantitatif aidera les chercheurs et les étudiants à apprendre de nouvelles opportunités.

This Article is written as a summary article by Marktechpost Staff based on the paper 'Solving Quantitative Reasoning Problems with Language Models'. All Credit For This Research Goes To Researchers on This Project. Checkout the paper and blog post. Please Don't Forget To Join Our ML Subreddit