Étapes pour éviter la surutilisation et l’utilisation abusive de l’apprentissage automatique dans la recherche clinique – Nature Medicine

Le terme surutilisation fait référence à l’adoption inutile de techniques d’IA ou de ML avancées là où des méthodologies alternatives, fiables ou supérieures existent déjà. Dans de tels cas, l’utilisation de techniques d’IA et de ML n’est pas nécessairement inappropriée ou malsaine, mais la justification d’une telle recherche est peu claire ou artificielle : par exemple, une nouvelle technique peut être proposée qui ne fournit aucune nouvelle réponse significative.

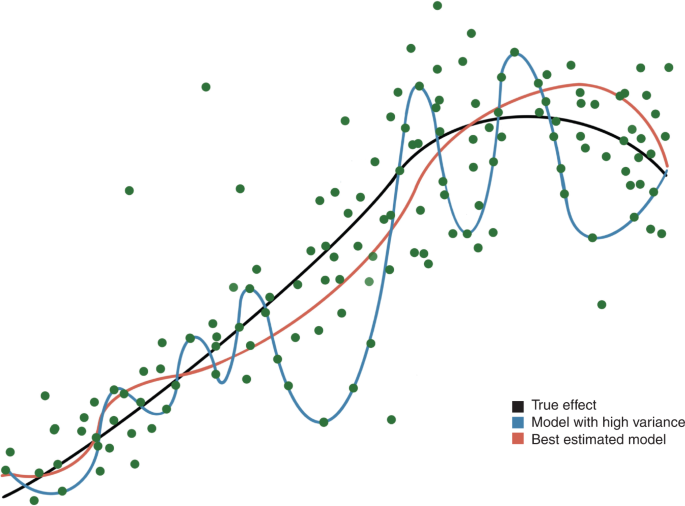

De nombreuses études cliniques ont utilisé des techniques de ML pour obtenir des performances respectables ou impressionnantes, comme le montrent les valeurs d’aire sous la courbe (AUC) comprises entre 0,80 et 0,90, voire > 0,90 (Encadré 1). Une AUC élevée n’est pas nécessairement une marque de qualité, car le modèle ML peut être sur-ajusté (Fig. 1). Lorsqu’une technique de régression traditionnelle est appliquée et comparée aux algorithmes ML, les modèles ML plus sophistiqués n’offrent souvent que des gains de précision marginaux, présentant un compromis discutable entre la complexité et la précision du modèle.1,2,8,9,10,11,12. Même des AUC très élevées ne sont pas des garanties de robustesse, car une AUC de 0,99 avec un taux d’événements global <1 % est possible, et conduirait à prédire correctement tous les cas négatifs, alors que les quelques événements positifs ne l'étaient pas.

Étant donné un ensemble de données avec des points de données (points verts) et un effet réel (ligne noire), un modèle statistique vise à estimer l’effet réel. La ligne rouge illustre une estimation proche, tandis que la ligne bleue illustre un modèle ML surajusté avec une dépendance excessive aux valeurs aberrantes. Un tel modèle peut sembler fournir d’excellents résultats pour cet ensemble de données particulier, mais ne fonctionne pas bien dans un ensemble de données différent (externe).

Il existe une distinction importante entre une amélioration statistiquement significative et une amélioration cliniquement significative des performances du modèle. Les techniques d’apprentissage automatique offrent sans aucun doute des moyens puissants pour traiter les problèmes de prédiction impliquant des données avec des relations non linéaires ou complexes de grande dimension (tableau 1). En revanche, de nombreux problèmes de prédiction médicale simples sont intrinsèquement linéaires, avec des caractéristiques qui sont choisies parce qu’elles sont connues pour être de bons prédicteurs, généralement sur la base de recherches antérieures ou de considérations mécanistes. Dans ces cas, il est peu probable que les méthodes de BC apportent une amélioration substantielle de la discrimination2. Contrairement au contexte d’ingénierie, où toute amélioration des performances peut améliorer le système dans son ensemble, de modestes améliorations de la précision des prédictions médicales sont peu susceptibles d’entraîner une différence dans l’action clinique.

Les techniques de ML doivent être évaluées par rapport aux méthodologies statistiques traditionnelles avant d’être déployées. Si l’objectif d’une étude est de développer un modèle prédictif, les algorithmes ML doivent être comparés à un ensemble prédéfini de techniques de régression traditionnelles pour le score de Brier (une métrique d’évaluation similaire à l’erreur quadratique moyenne, utilisée pour vérifier la qualité d’un score de probabilité prédit ), la discrimination (ou AUC) et l’étalonnage. Le modèle doit ensuite être validé en externe. Les méthodes analytiques et les mesures de performance sur lesquelles elles sont comparées doivent être spécifiées dans un protocole d’étude prospective et doivent aller au-delà de la performance globale, de la discrimination et de l’étalonnage pour inclure également des mesures liées au sur-ajustement.

A l’inverse, certains algorithmes sont capables de dire je ne sais pas face à des données inconnues13un résultat important mais souvent sous-estimé, car le fait de savoir qu’une prédiction est très incertaine peut, en soi, être cliniquement exploitable.