Se tenir au courant de l’IA : liste de contrôle de la cybersécurité et de la gouvernance de l’OWASP LLM AI

Les leaders de la cybersécurité se sont efforcés de suivre le rythme de l’exploration, de l’adoption et de l’utilisation rapides de leurs organisations de grands modèles de langage (LLM) et d’IA générative. Des entreprises telles que OpenAI, Anthropic, Google et Microsoft ont connu une croissance exponentielle de l’utilisation de leurs offres d’IA générative et de LLM.

Les alternatives open source ont également connu une croissance significative, avec des communautés d’IA telles que Hugging Face devenant largement utilisées, proposant des modèles, des ensembles de données et des applications à la communauté technologique. Heureusement, à mesure que l’utilisation de l’IA générative et des LLM a évolué, les conseils d’organisations leaders du secteur telles que l’OWASP, OpenSSF, CISA et d’autres ont également évolué.

L’OWASP a notamment joué un rôle essentiel en fournissant des ressources clés, telles que son OWASP AI Exchange, son AI Security and Privacy Guide et son LLM Top 10. Récemment, le groupe a publié sa LLM AI Cybersecurity & Governance Checklist, qui fournit des conseils indispensables pour suivre Développements de l’IA.

L’OWASP fait une distinction entre les types d’IA

La liste de contrôle propose des distinctions entre l’IA et le ML plus larges et l’IA et les LLM génératifs. L’IA générative est définie comme un type d’apprentissage automatique qui se concentre sur la création de nouvelles données, tandis que les LLM sont un type de modèle d’IA utilisé pour traiter et générer un texte de type humain. Ils font des prédictions en fonction des entrées qui leur sont fournies et la sortie est humaine. comme dans la nature. Nous le voyons avec des outils de pointe tels que ChatGPT, qui compte déjà plus de 180 millions d’utilisateurs avec plus de 1,6 milliard de visites de site rien qu’en janvier 2024.

Le projet LLM Top 10 a produit la liste de contrôle pour aider les dirigeants et les praticiens de la cybersécurité à suivre le rythme de l’évolution rapide de l’espace et à se protéger contre les risques associés à l’adoption et à l’utilisation rapides et non sécurisées de l’IA, en particulier des offres d’IA générative et de LLM.

Il peut aider les praticiens à identifier les principales menaces et à garantir que l’organisation dispose de contrôles de sécurité fondamentaux pour aider à sécuriser et à habiliter l’entreprise à mesure qu’elle mûrit dans son approche d’adoption d’outils, de services et de produits d’IA générative et de LLM.

Le sujet de l’IA peut être incroyablement vaste, c’est pourquoi la liste de contrôle vise à aider les dirigeants à identifier rapidement certains des principaux risques associés à l’IA générative et aux LLM et à les doter des mesures d’atténuation associées et des considérations clés pour limiter les risques pour leurs organisations respectives. souligne que la liste de contrôle n’est pas exhaustive et continuera d’évoluer à mesure que l’utilisation de l’IA générative, des LLM et des outils eux-mêmes évoluent et mûrissent.

Liste de contrôle des catégories de menaces, des stratégies et des types de déploiement

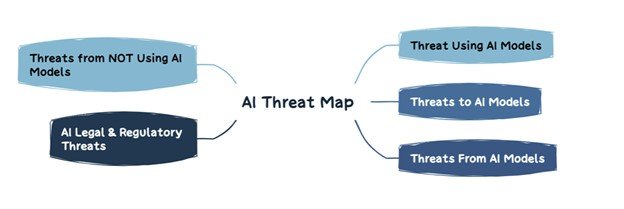

Il existe différentes catégories de menaces LLM, qui sont capturées dans l’image ci-dessous :

Liste de contrôle OWASP LLM AI Cybersécurité et gouvernance

Source : Liste de contrôle OWASP LLM AI Cybersécurité et gouvernance

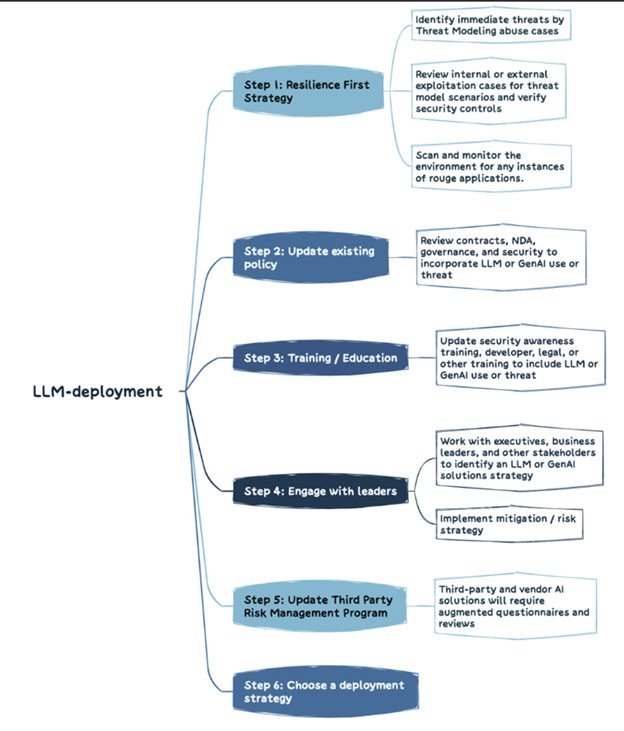

Les organisations doivent déterminer leur stratégie LLM. C’est essentiellement ainsi que les organisations géreront les risques uniques associés à l’IA générative et aux LLM et mettront en œuvre une gouvernance organisationnelle et des contrôles de sécurité pour atténuer ces risques. La publication présente une approche pratique en six étapes permettant aux organisations de développer leur stratégie LLM, comme illustré ci-dessous :

Source : Liste de contrôle OWASP LLM AI Cybersécurité et gouvernance

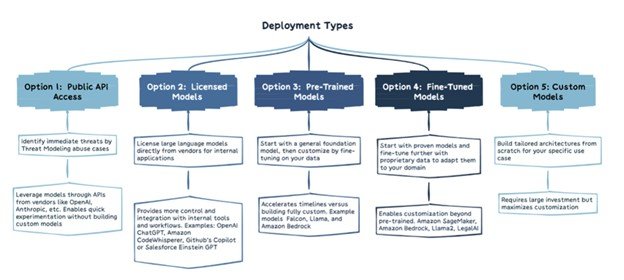

Il existe également différents types de déploiement LLM, chacun avec ses propres considérations uniques, comme indiqué ci-dessous. Ils vont de l’accès public au point d’accès et des modèles sous licence jusqu’aux modèles personnalisés :

Source : Liste de contrôle OWASP LLM AI Cybersécurité et gouvernance

Principaux domaines d’intérêt de la liste de contrôle de l’OWASP

Voici une présentation pas à pas des domaines de la liste de contrôle identifiés et quelques points clés à retenir de chacun.

Risque contradictoire

Ce domaine implique à la fois les concurrents et les attaquants et se concentre non seulement sur le paysage des attaques mais aussi sur le paysage commercial. Cela implique de comprendre comment les concurrents utilisent l’IA pour générer des résultats commerciaux, ainsi que de mettre à jour les processus et politiques internes tels que les plans de réponse aux incidents (IRP) pour tenir compte des attaques et des incidents génératifs d’IA.

Modélisation des menaces

La modélisation des menaces est une technique de sécurité qui continue de gagner du terrain dans le cadre de la campagne plus large en faveur de systèmes sécurisés dès la conception, préconisée par la CISA et d’autres. Cela implique de réfléchir à la manière dont les attaquants peuvent utiliser les LLM et l’IA générative pour accélérer l’exploitation, à la capacité de l’entreprise à détecter l’utilisation malveillante des LLM et d’examiner si l’organisation peut protéger les connexions aux LLM et aux plates-formes d’IA générative à partir des systèmes et environnements internes.

Inventaire des actifs d’IA

L’adage selon lequel vous ne pouvez pas protéger ce que vous ne savez pas posséder s’applique également au monde de l’IA générative et des LLM. Ce domaine de la liste de contrôle implique de disposer d’un inventaire des actifs d’IA pour les solutions développées en interne ainsi que pour les outils et plates-formes externes.

Il est essentiel de comprendre non seulement les outils et services utilisés par une organisation, mais également leur propriété, en termes de qui sera responsable de leur utilisation. Il existe également des recommandations pour inclure des composants d’IA dans les SBOM et cataloguer les sources de données d’IA et leur sensibilité respective.

En plus d’avoir un inventaire des outils existants utilisés, il devrait également y avoir un processus pour intégrer et retirer les futurs outils et services de l’inventaire organisationnel en toute sécurité.

Formation sur la sécurité et la confidentialité de l’IA

On dit souvent en plaisantant que les humains sont le maillon le plus faible, mais cela n’est pas nécessairement le cas si une organisation intègre correctement la formation sur la sécurité et la confidentialité de l’IA dans son parcours d’adoption de l’IA générative et du LLM.

Cela implique d’aider le personnel à comprendre les initiatives génératives d’IA/LLM existantes, ainsi que la technologie au sens large et son fonctionnement, ainsi que les principales considérations de sécurité, telles que les fuites de données. De plus, il est essentiel d’établir une culture de confiance et de transparence, afin que le personnel se sente à l’aise pour partager quels outils et services d’IA générative et LLM sont utilisés, et comment.

Un élément clé pour éviter l’utilisation de l’IA fantôme sera cette confiance et cette transparence au sein de l’organisation, sinon les gens continueront à utiliser ces plates-formes et ne le porteront tout simplement pas à l’attention des équipes informatiques et de sécurité par crainte de conséquences ou de sanctions.

Établir des analyses de rentabilisation pour l’utilisation de l’IA

Cela peut paraître surprenant, mais tout comme pour le cloud avant lui, la plupart des organisations n’établissent pas d’analyse de rentabilisation stratégique cohérente pour l’utilisation de nouvelles technologies innovantes, notamment l’IA générative et le LLM. Il est facile de se laisser prendre au piège du battage médiatique et de ressentir le besoin de se joindre à la course ou de se laisser distancer. Mais sans une analyse de rentabilisation solide, l’organisation risque de mauvais résultats, des risques accrus et des objectifs opaques.

Gouvernance

Sans gouvernance, la responsabilité et les objectifs clairs sont presque impossibles. Cette zone de la liste de contrôle implique l’établissement d’un tableau RACI IA pour les efforts d’IA de l’organisation, la documentation et l’attribution des responsables des risques et de la gouvernance et l’établissement de politiques et de processus d’IA à l’échelle de l’organisation.

Légal

Même si elles nécessitent évidemment la contribution d’experts juridiques au-delà du domaine cybernétique, les implications juridiques de l’IA ne doivent pas être sous-estimées. Ils évoluent rapidement et pourraient avoir un impact sur la situation financière et la réputation de l’organisation.

Ce domaine implique une longue liste d’activités, telles que les garanties de produits impliquant l’IA, les CLUF IA, les droits de propriété sur le code développé avec des outils d’IA, les risques liés à la propriété intellectuelle et les dispositions d’indemnisation contractuelle, pour n’en nommer que quelques-unes. Pour le dire succinctement, assurez-vous d’engager votre équipe juridique ou vos experts pour déterminer les différentes activités juridiques que l’organisation devrait entreprendre dans le cadre de son adoption et de son utilisation de l’IA générative et des LLM.

Réglementaire

Pour s’appuyer sur les discussions juridiques, les réglementations évoluent également rapidement, comme la loi européenne sur l’IA, et d’autres suivront sans doute bientôt. Les organisations doivent déterminer les exigences de conformité de leur pays, de leur état et de leur gouvernement en matière d’IA, leur consentement concernant l’utilisation de l’IA à des fins spécifiques telles que la surveillance des employés et comprendre clairement comment leurs fournisseurs d’IA stockent et suppriment les données et réglementent leur utilisation.

Utiliser ou mettre en œuvre des solutions LLM

L’utilisation de solutions LLM nécessite des considérations et des contrôles de risques spécifiques. La liste de contrôle évoque des éléments tels que le contrôle d’accès, la sécurité du pipeline de formation, la cartographie des flux de données et la compréhension des vulnérabilités existantes ou potentielles dans les modèles LLM et les chaînes d’approvisionnement. De plus, il est nécessaire de demander des audits à des tiers, des tests d’intrusion et même des révisions de code pour les fournisseurs, tant au départ que de manière continue.

Tests, évaluation, vérification et validation (TEVV)

Le processus TEVV est celui spécifiquement recommandé par le NIST dans son AI Framework. Cela implique d’établir des tests, des évaluations, des vérifications et des validations continus tout au long des cycles de vie des modèles d’IA, ainsi que de fournir des mesures exécutives sur la fonctionnalité, la sécurité et la fiabilité du modèle d’IA.

Cartes modèles et cartes de risques

Pour déployer les LLM de manière éthique, la liste de contrôle appelle à l’utilisation de modèles et de cartes de risques, qui peuvent être utilisées pour permettre aux utilisateurs de comprendre et de faire confiance aux systèmes d’IA, ainsi que pour aborder ouvertement les conséquences potentiellement négatives telles que les préjugés et la confidentialité.

Ces cartes peuvent inclure des éléments tels que les détails du modèle, l’architecture, les méthodologies de données de formation et les mesures de performances. L’accent est également mis sur la prise en compte des considérations et des préoccupations en matière d’IA responsable en matière d’équité et de transparence.

RAG : optimisations LLM

La génération augmentée par récupération (RAG) est un moyen d’optimiser les capacités des LLM lorsqu’il s’agit de récupérer des données pertinentes à partir de sources spécifiques. Cela fait partie de l’optimisation des modèles pré-entraînés ou du recyclage des modèles existants sur de nouvelles données pour améliorer les performances. La liste de contrôle recommandait de mettre en œuvre RAG pour maximiser la valeur et l’efficacité des LLM à des fins organisationnelles.

Équipe rouge IA

Enfin, la liste de contrôle appelle à l’utilisation de l’équipe rouge de l’IA, qui émule les attaques contradictoires des systèmes d’IA pour identifier les vulnérabilités et valider les contrôles et défenses existants. Il souligne que l’équipe rouge à elle seule ne constitue pas une solution ou une approche globale pour sécuriser l’IA générative et les LLM, mais devrait faire partie d’une approche globale pour garantir l’adoption de l’IA générative et des LLM.

Cela dit, il convient de noter que les organisations doivent clairement comprendre les exigences et la capacité d’équiper les services et les systèmes des fournisseurs externes d’IA générative et de LLM pour éviter de violer les politiques ou même de se retrouver également en difficulté juridique.