Qu’est-ce que l’informatique IA ?

Le boulier, le sextant, la règle à calcul et l’ordinateur. Les instruments mathématiques marquent l’histoire du progrès humain.

Ils ont permis le commerce et aidé à naviguer sur les océans, ainsi qu’à améliorer la compréhension et la qualité de vie.

Le dernier outil propulsant la science et l’industrie est l’IA computing.

Définition de l’informatique IA

L’informatique IA est le processus mathématique intensif de calcul d’algorithmes d’apprentissage automatique, utilisant généralement des systèmes et des logiciels accélérés. Il peut extraire de nouvelles informations à partir d’ensembles de données massifs, en apprenant de nouvelles compétences en cours de route.

C’est la technologie la plus transformationnelle de notre époque, car nous vivons à une époque centrée sur les données, et l’informatique IA peut trouver des modèles qu’aucun humain ne pourrait trouver.

Par exemple, American Express utilise l’informatique IA pour détecter la fraude dans des milliards de transactions annuelles par carte de crédit. Les médecins l’utilisent pour trouver des tumeurs, trouvant de minuscules anomalies dans des montagnes d’images médicales.

Trois étapes vers l’IA Computing

Avant d’aborder les nombreux cas d’utilisation de l’informatique IA, explorons comment cela fonctionne.

Tout d’abord, les utilisateurs, souvent des scientifiques des données, organisent et préparent des ensembles de données, une étape appelée extraction/transformation/chargement, ou ETL. Ce travail peut désormais être accéléré sur les GPU NVIDIA avec Apache Spark 3.0, l’un des moteurs open source les plus populaires pour l’exploration de données volumineuses.

Deuxièmement, les data scientists choisissent ou conçoivent les modèles d’IA qui conviennent le mieux à leurs applications.

Certaines entreprises conçoivent et forment leurs propres modèles à partir de zéro parce qu’elles sont pionnières dans un nouveau domaine ou qu’elles recherchent un avantage concurrentiel. Ce processus nécessite une certaine expertise et potentiellement un supercalculateur d’IA, capacités offertes par NVIDIA.

De nombreuses entreprises choisissent des modèles d’IA pré-entraînés qu’elles peuvent personnaliser selon les besoins de leurs applications. NVIDIA fournit des dizaines de modèles et d’outils pré-entraînés pour les personnaliser sur NGC, un portail de logiciels, de services et d’assistance.

Troisièmement, les entreprises passent au crible leurs données à travers leurs modèles. Cette étape clé, appelée inférenceest l’endroit où l’IA fournit des informations exploitables.

Le processus en trois étapes implique un travail acharné, mais une aide est disponible pour que tout le monde puisse utiliser l’informatique IA.

Par exemple, NVIDIA TAO Toolkit peut regrouper les trois étapes en une seule à l’aide de l’apprentissage par transfert, un moyen d’adapter un modèle d’IA existant à une nouvelle application sans avoir besoin d’un grand ensemble de données. De plus, NVIDIA LaunchPad offre aux utilisateurs une formation pratique sur le déploiement de modèles pour une grande variété de cas d’utilisation.

À l’intérieur d’un modèle d’IA

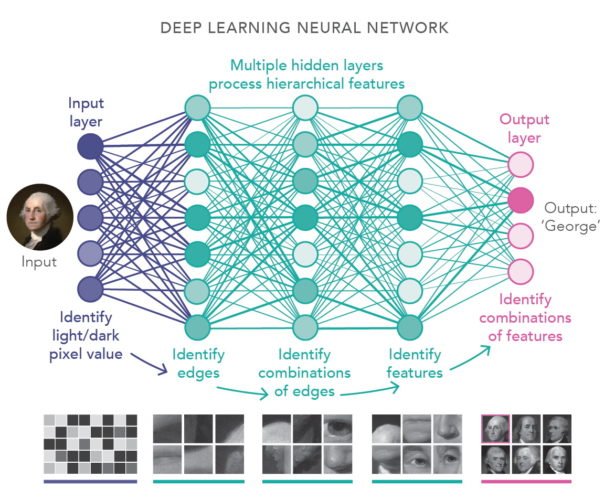

Les modèles d’IA sont appelés réseaux de neurones car ils sont inspirés des connexions de type Web dans le cerveau humain.

Si vous découpez l’un de ces modèles d’IA, cela pourrait ressembler à une lasagne mathématique, composée de couches d’équations d’algèbre linéaire. L’une des formes les plus populaires d’IA est appelée apprentissage en profondeur car elle utilise de nombreuses couches.

Si vous effectuez un zoom avant, vous verrez que chaque couche est composée de piles d’équations. Chacun représente la probabilité qu’une donnée soit liée à une autre.

L’informatique IA multiplie chaque pile d’équations dans chaque couche pour trouver des modèles. C’est un travail énorme qui nécessite des processeurs hautement parallèles partageant d’énormes quantités de données sur des réseaux informatiques rapides.

Le calcul GPU rencontre l’IA

Les GPU sont les moteurs de facto de l’informatique IA.

NVIDIA a lancé le premier GPU en 1999 pour restituer des images 3D pour les jeux vidéo, un travail qui nécessitait des calculs massivement parallèles.

L’informatique GPU s’est rapidement répandue dans les serveurs graphiques pour les films à succès. Les scientifiques et les chercheurs ont intégré des GPU dans les plus grands supercalculateurs du monde pour tout étudier, de la chimie de minuscules molécules à l’astrophysique des galaxies lointaines.

Lorsque l’informatique IA est apparue il y a plus de dix ans, les chercheurs ont rapidement adopté la plate-forme programmable de NVIDIA pour le traitement parallèle. La vidéo ci-dessous célèbre cette brève histoire du GPU.

L’histoire de l’informatique IA

L’idée de l’intelligence artificielle remonte au moins à Alan Turing, le mathématicien britannique qui a aidé à déchiffrer des messages codés pendant la Seconde Guerre mondiale.

Ce que nous voulons, c’est une machine qui peut apprendre de l’expérience, a déclaré Turing lors d’une conférence en 1947 à Londres.

Reconnaissant ses idées, NVIDIA a nommé l’une de ses architectures informatiques pour lui.

La vision de Turing est devenue une réalité en 2012 lorsque les chercheurs ont développé des modèles d’IA capables de reconnaître les images plus rapidement et plus précisément que les humains. Les résultats du concours ImageNet ont également considérablement accéléré les progrès de la vision par ordinateur.

Aujourd’hui, des entreprises telles que Landing AI, fondée par Andrew Ng, une sommité de l’apprentissage automatique, appliquent l’IA et la vision par ordinateur pour rendre la fabrication plus efficace. Et l’IA apporte une vision humaine aux sports, aux villes intelligentes et plus encore.

AI Computing lance l’IA conversationnelle

L’informatique IA a fait d’énormes progrès dans le traitement du langage naturel après l’invention du modèle de transformateur en 2017. Elle a lancé une technique d’apprentissage automatique appelée attention qui peut capturer le contexte dans des données séquentielles comme le texte et la parole.

Aujourd’hui, l’IA conversationnelle est largement répandue. Il analyse les phrases que les utilisateurs saisissent dans les champs de recherche. Il lit les messages texte lorsque vous conduisez et vous permet de dicter des réponses.

Ces grands modèles de langage trouvent également des applications dans la découverte de médicaments, la traduction, les chatbots, le développement de logiciels, l’automatisation des centres d’appels, etc.

IA + graphiques créent des mondes 3D

Dans de nombreux domaines, souvent inattendus, les utilisateurs ressentent la puissance de l’informatique IA.

Les derniers jeux vidéo atteignent de nouveaux niveaux de réalisme grâce au ray tracing en temps réel et à NVIDIA DLSS, qui utilise l’IA pour offrir un jeu ultra-fluide sur la plate-forme GeForce RTX.

Ce n’est que le début. Le domaine émergent des graphiques neuronaux accélérera la création de mondes virtuels pour peupler le métaverse, l’évolution 3D d’Internet.

Pour lancer ce travail, NVIDIA a publié plusieurs outils graphiques neuronaux en août.

Cas d’utilisation pour l’IA Computing

Voitures, usines et entrepôts

Les constructeurs automobiles adoptent l’informatique IA pour offrir une expérience de conduite plus fluide et plus sûre et offrir des capacités d’infodivertissement intelligentes aux passagers.

Mercedes-Benz travaille avec NVIDIA pour développer des véhicules définis par logiciel. Ses flottes à venir offriront des capacités de conduite intelligentes et automatisées alimentées par un ordinateur centralisé NVIDIA DRIVE Orin. Les systèmes seront testés et validés dans le centre de données à l’aide du logiciel DRIVE Sim, basé sur NVIDIA Omniverse, pour s’assurer qu’ils peuvent gérer en toute sécurité tous les types de scénarios.

Au CES, le constructeur automobile a annoncé qu’il utiliserait également Omniverse pour concevoir et planifier des installations de fabrication et d’assemblage sur ses sites dans le monde entier.

BMW Group fait également partie des nombreuses entreprises qui créent des jumeaux numériques d’usines compatibles avec l’IA dans NVIDIA Omniverse, ce qui rend les usines plus efficaces. C’est une approche également adoptée par des géants de la consommation comme PepsiCo pour ses centres logistiques comme le montre la vidéo ci-dessous.

Dans les usines et les entrepôts, les robots autonomes améliorent encore l’efficacité de la fabrication et de la logistique. Beaucoup sont alimentés par la plate-forme d’intelligence artificielle NVIDIA Jetson edge et formés avec l’IA dans les simulations et les jumeaux numériques à l’aide de NVIDIA Isaac Sim.

En 2022, même les tracteurs et les tondeuses à gazon sont devenus autonomes grâce à l’IA.

En décembre, Monarch Tractor, une startup basée à Livermore, en Californie, a lancé un véhicule électrique alimenté par l’IA pour apporter l’automatisation à l’agriculture. En mai, Scythe, basé à Boulder, Colorado, a lancé son M.52 (ci-dessous), une tondeuse à gazon électrique autonome contenant huit caméras et plus d’une douzaine de capteurs.

Sécurisation des réseaux, séquençage des gènes

Le nombre et la variété des cas d’utilisation de l’informatique IA sont stupéfiants.

Les logiciels de cybersécurité détectent plus rapidement le phishing et d’autres menaces réseau grâce à des techniques basées sur l’IA telles que les empreintes digitales numériques.

Dans le domaine de la santé, des chercheurs ont battu un record en janvier 2022 en séquençant un génome entier en bien moins de huit heures grâce à l’informatique IA. Leur travail (décrit dans la vidéo ci-dessous) pourrait conduire à des remèdes contre des maladies génétiques rares.

L’informatique IA est à l’œuvre dans les banques, les magasins de détail et les bureaux de poste. Il est également utilisé dans les réseaux de télécommunications, de transport et d’énergie.

Par exemple, la vidéo ci-dessous montre comment Siemens Gamesa utilise des modèles d’IA pour simuler des parcs éoliens et augmenter la production d’énergie.

Alors que les techniques informatiques d’IA d’aujourd’hui trouvent de nouvelles applications, les chercheurs inventent des méthodes plus récentes et plus puissantes.

Une autre classe puissante de réseaux de neurones, les modèles de diffusion, est devenue populaire en 2022 car ils pouvaient transformer des descriptions textuelles en images fascinantes. Les chercheurs s’attendent à ce que ces modèles soient appliqués à de nombreuses utilisations, élargissant encore l’horizon de l’informatique IA.