L’accès assisté d’Apple simplifie iOS 16 pour les personnes souffrant de troubles cognitifs | Engadget

À quelques jours de la Journée mondiale de sensibilisation à l’accessibilité, Apple présente en avant-première une série de nouvelles fonctionnalités iOS pour l’accessibilité cognitive, ainsi que Live Speech, Personal Voice, etc. La société a déclaré qu’elle travaillait en « collaboration approfondie » avec des groupes communautaires représentant les utilisateurs handicapés et s’appuyait sur « les progrès du matériel et des logiciels, y compris l’apprentissage automatique sur appareil » pour les faire fonctionner.

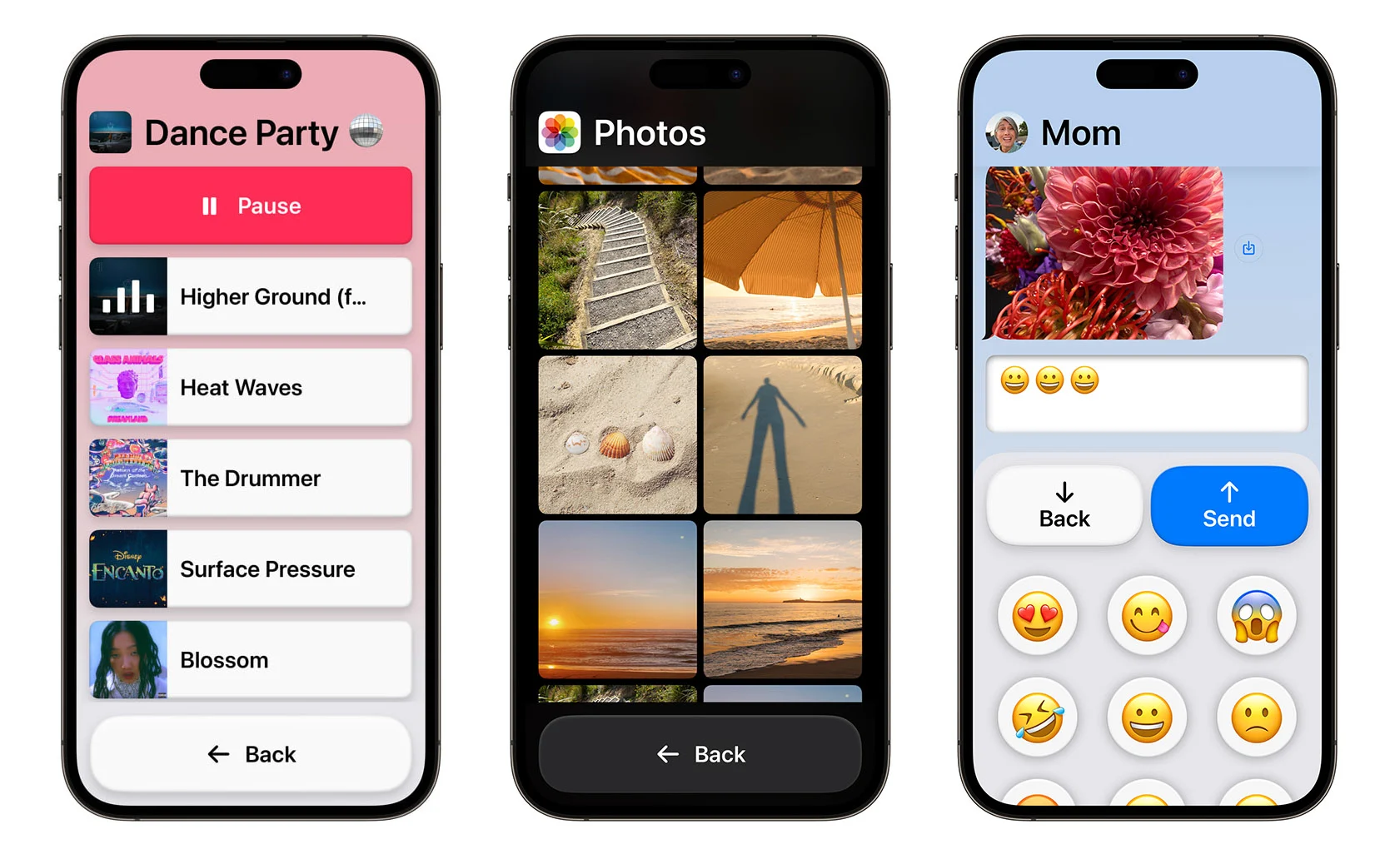

La plus grande mise à jour est « Assistive Access » conçue pour aider les utilisateurs souffrant de troubles cognitifs. Essentiellement, il offre une expérience personnalisée et simplifiée pour les applications de téléphone, FaceTime, Messages, Appareil photo, Photos et Musique. Cela inclut une « interface distincte avec des boutons à contraste élevé et de grandes étiquettes de texte » ainsi que des outils qui peuvent être personnalisés par des supporters de confiance pour chaque individu.

Pomme

« Par exemple, pour les utilisateurs qui préfèrent communiquer visuellement, Messages comprend un clavier uniquement emoji et la possibilité d’enregistrer un message vidéo à partager avec leurs proches. Les utilisateurs et les supporters de confiance peuvent également choisir entre une disposition plus visuelle basée sur une grille pour leur Écran d’accueil et applications, ou une disposition basée sur des lignes pour les utilisateurs qui préfèrent le texte », a écrit Apple.

L’objectif est de faire tomber les barrières technologiques pour les personnes en situation de handicap cognitif. « La communauté des personnes handicapées intellectuelles et développementales déborde de créativité, mais la technologie pose souvent des barrières physiques, visuelles ou de connaissances pour ces personnes », a déclaré Katy Schmid de The Arc dans un communiqué. « Avoir une fonctionnalité qui offre une expérience cognitivement accessible sur iPhone ou iPad, ce qui signifie des portes plus ouvertes à l’éducation, à l’emploi, à la sécurité et à l’autonomie. Cela signifie élargir les mondes et élargir le potentiel. »

Une autre nouvelle fonctionnalité importante est Live Speech et Personal Voice pour iPhone, iPad et Mac. Live Speech permet aux utilisateurs de taper ce qu’ils veulent dire et de le faire dire à voix haute pendant les appels téléphoniques et FaceTime ou pour les conversations en personne. Pour les utilisateurs qui peuvent encore parler mais qui risquent de perdre leur capacité à le faire en raison d’un diagnostic de SLA ou d’autres conditions, il existe la fonction Personal Voice.

Pomme

Il leur permet de créer une voix qui ressemble à la leur en lisant avec un ensemble aléatoire d’invites de texte pour enregistrer 15 minutes d’audio sur iPhone ou iPad. Il utilise ensuite l’apprentissage automatique sur l’appareil pour garder les informations de l’utilisateur privées et fonctionne avec Live Speech afin que les utilisateurs puissent parler efficacement avec d’autres en utilisant une version de leur propre voix. « Si vous pouvez dire [your friends and family] vous les aimez, d’une voix qui vous ressemble, cela fait toute la différence dans le monde », a déclaré Philip Green, membre du conseil d’administration de Team Gleason et défenseur de la SLA, dont la propre voix a été affectée par la SLA.

Enfin, Apple a introduit une fonction Point and Speak dans la loupe pour aider les utilisateurs malvoyants à interagir avec des objets physiques. « Par exemple, lors de l’utilisation d’un appareil électroménager tel qu’un four à micro-ondes, Point and Speak combine les entrées de l’application Appareil photo, le scanner LiDAR et l’apprentissage automatique sur l’appareil pour annoncer le texte sur chaque bouton lorsque les utilisateurs déplacent leur doigt sur le clavier », il a écrit. La fonctionnalité est intégrée à l’application Magnifier sur iPhone et iPad, et peut être utilisée avec d’autres fonctionnalités Magnifier telles que la détection de personnes, la détection de porte et autres.

Parallèlement aux nouvelles fonctions, Apple présente de nouvelles fonctionnalités, des collections organisées et bien plus encore pour la Journée mondiale de sensibilisation à l’accessibilité. Celles-ci incluent un lancement de SignTime en Allemagne, en Italie, en Espagne et en Corée du Sud pour connecter les clients Apple Store et Support avec des interprètes en langue des signes à la demande, ainsi que des sessions d’information sur l’accessibilité dans certains magasins Apple Store du monde entier. Il propose également des podcasts, des films et plus encore sur l’impact de la technologie accessible. Le nouvel accès assisté et d’autres fonctionnalités devraient être déployés plus tard cette année, a déclaré Apple pour en savoir plus, consultez son communiqué de presse.

Tous les produits recommandés par Engadget sont sélectionnés par notre équipe éditoriale, indépendante de notre maison mère. Certaines de nos histoires incluent des liens d’affiliation. Si vous achetez quelque chose via l’un de ces liens, nous pouvons gagner une commission d’affiliation. Tous les prix sont corrects au moment de la publication.