Bossware arrive pour presque tous les travailleurs : le logiciel dont vous ne vous rendez peut-être pas compte vous surveille

Oorsque le travail d’un jeune analyste basé sur la côte est bien appelé James s’est éloigné avec la pandémie, il n’envisageait aucun problème. L’entreprise, un grand détaillant américain pour lequel il est salarié depuis plus d’une demi-décennie, lui a fourni un ordinateur portable, et sa maison est devenue son nouveau bureau. Membre d’une équipe traitant des problèmes de chaîne d’approvisionnement, le travail était chargé, mais il n’avait jamais été réprimandé pour ne pas avoir travaillé assez dur.

Ce fut donc un choc lorsque son équipe a été transportée un jour à la fin de l’année dernière à une réunion en ligne pour se faire dire qu’il y avait des lacunes dans son travail : en particulier des périodes où des personnes, y compris James lui-même, il a été informé plus tard qu’elles ne saisissaient pas d’informations dans la base de données de l’entreprise.

Pour autant que les membres de l’équipe le sachent, personne ne les avait surveillés au travail. Mais alors qu’il devenait clair ce qui s’était passé, James devint furieux.

Une entreprise peut-elle vraiment utiliser des outils de surveillance informatique connus sous le nom de bossware pour dire si vous êtes productif au travail ? Ou si vous êtes sur le point de vous enfuir chez un concurrent possédant des connaissances exclusives ? Ou même, tout simplement, si vous êtes heureux ?

De nombreuses entreprises aux États-Unis et en Europe semblent désormais controversées vouloir essayer, stimulées par les énormes changements dans les habitudes de travail pendant la pandémie, au cours desquels d’innombrables emplois de bureau ont déménagé et semblent prêts à y rester ou à devenir hybrides. Cela se heurte à une autre tendance des employeurs à quantifier le travail, qu’il soit physique ou numérique, dans l’espoir de gagner en efficacité.

L’essor des logiciels de surveillance est l’une des histoires inédites de la pandémie de Covid, déclare Andrew Pakes, secrétaire général adjoint de Prospect, un syndicat britannique.

Cela arrive pour presque tous les types de travailleurs, déclare Wilneida Negrn, directrice de la recherche et des politiques chez Coworker, une organisation à but non lucratif basée aux États-Unis pour aider les travailleurs à s’organiser. Les emplois axés sur le savoir qui ont disparu pendant la pandémie sont un domaine de croissance particulier.

Une enquête réalisée en septembre dernier par le site d’examen Digital.com auprès de 1 250 employeurs américains a révélé que 60 % des employés à distance utilisent un logiciel de surveillance du travail, le plus souvent pour suivre la navigation sur le Web et l’utilisation des applications. Et près de neuf entreprises sur 10 ont déclaré avoir licencié des travailleurs après avoir mis en place un logiciel de surveillance.

Le nombre et la gamme d’outils désormais proposés pour surveiller en permanence l’activité numérique des employés et fournir un retour d’information aux managers sont remarquables. La technologie de suivi peut également enregistrer les frappes au clavier, prendre des captures d’écran, enregistrer les mouvements de la souris, activer les webcams et les microphones ou prendre périodiquement des photos à l’insu des employés. Et un sous-ensemble croissant intègre l’intelligence artificielle (IA) et des algorithmes complexes pour donner un sens aux données collectées.

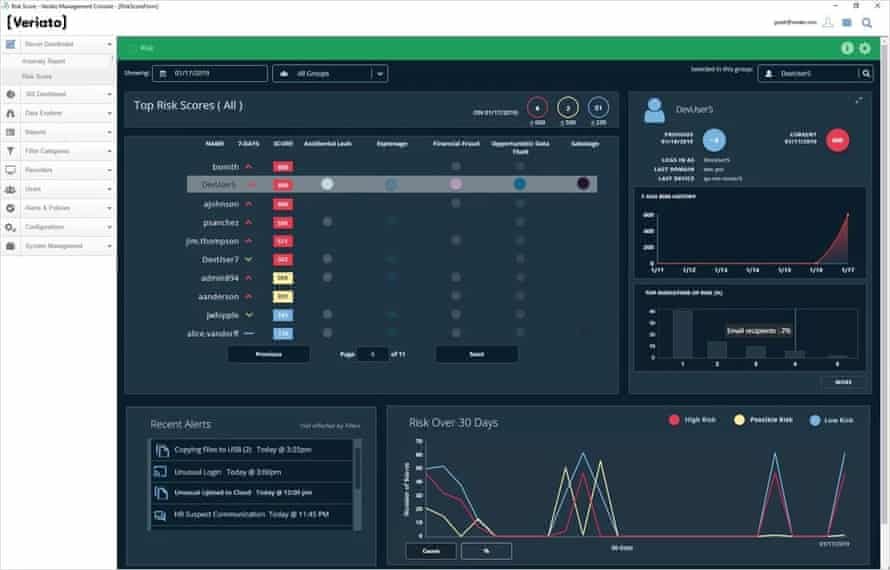

Une technologie de surveillance de l’IA, Veriato, donne aux travailleurs un score de risque quotidien qui indique la probabilité qu’ils constituent une menace pour la sécurité de leur employeur. Cela peut être dû au fait qu’ils peuvent accidentellement divulguer quelque chose ou parce qu’ils ont l’intention de voler des données ou de la propriété intellectuelle.

Le score est composé de nombreux composants, mais il inclut ce qu’une IA voit lorsqu’elle examine le texte des e-mails et des chats d’un travailleur pour soi-disant déterminer son sentiment, ou ses changements, qui peuvent indiquer du mécontentement. L’entreprise peut ensuite soumettre ces personnes à un examen plus approfondi.

Il s’agit vraiment de protéger les consommateurs et les investisseurs ainsi que les employés contre les erreurs accidentelles, déclare Elizabeth Harz, PDG.

Une autre entreprise utilisant l’IA, RemoteDesk, propose un produit destiné aux travailleurs à distance dont le travail nécessite un environnement sécurisé, car ils traitent par exemple des détails de carte de crédit ou des informations de santé. Il surveille les travailleurs via leurs webcams avec une technologie de reconnaissance faciale et de détection d’objets en temps réel pour s’assurer que personne d’autre ne regarde leur écran et qu’aucun appareil d’enregistrement, comme un téléphone, n’est visible. Il peut même déclencher des alertes si un travailleur mange ou boit au travail, si une entreprise l’interdit.

La propre description de RemoteDesks de sa technologie pour l’obéissance au travail à domicile a causé consternation sur Twitter l’année dernière. (Ce langage n’a pas reflété l’intention de l’entreprise et a été modifié, a déclaré son PDG, Rajinish Kumar, au Guardian.)

Mais les outils qui prétendent évaluer la productivité des travailleurs semblent en passe de devenir les plus omniprésents. Fin 2020, Microsoft a déployé un nouveau produit appelé Productivity Score qui évaluait l’activité des employés dans sa suite d’applications, y compris la fréquence à laquelle ils assistaient à des réunions vidéo et envoyaient des e-mails. Un contrecoup généralisé s’en est suivi, et Microsoft s’est excusé et a réorganisé le produit afin que les travailleurs ne puissent pas être identifiés. Mais certaines petites entreprises repoussent joyeusement les limites.

Prodoscore, fondée en 2016, en est une. Son logiciel est utilisé pour surveiller environ 5 000 travailleurs dans diverses entreprises. Chaque employé obtient une note de productivité quotidienne sur 100 qui est transmise à un responsable d’équipe et à l’ouvrier, qui verront également leur classement parmi leurs pairs. Le score est calculé par un algorithme propriétaire qui pèse et agrège le volume d’entrée d’un travailleur dans toutes les applications professionnelles de l’entreprise, les e-mails, les téléphones, les applications de messagerie et les bases de données.

Seulement environ la moitié des clients de Prodoscores disent à leurs employés qu’ils sont surveillés à l’aide du logiciel (il en va de même pour Veriato). L’outil est convivial pour les employés, affirme le PDG Sam Naficy, car il donne aux employés un moyen clair de démontrer qu’ils sont réellement travail à la maison. [Just] gardez votre Prodoscore au nord de 70, dit Naficy. Et parce qu’il ne s’agit que de noter un travailleur en fonction de son activité, il ne s’accompagne pas des mêmes préjugés sexistes, raciaux ou autres que les gestionnaires humains, affirme l’entreprise.

Prodoscore ne suggère pas que les entreprises prennent des décisions conséquentes pour les travailleurs, par exemple concernant les primes, les promotions ou les licenciements en fonction de ses scores. Bien qu’en fin de compte, c’est leur discrétion, dit Naficy. Il s’agit plutôt d’une mesure complémentaire aux résultats réels des travailleurs, ce qui peut aider les entreprises voient comment les gens passent leur temps ou limitent le surmenage.

Naficy répertorie les entreprises juridiques et technologiques comme ses clients, mais ceux approchés par le Guardian ont refusé de parler de ce qu’ils font avec le produit. L’un, le principal éditeur de journaux américain Gannett, a répondu qu’il n’est utilisé que par une petite division de vente d’environ 20 personnes. Une société de vidéosurveillance nommée DTiQ est citée sur le site Web Prodoscores comme disant que la baisse des scores prédisait avec précision quels employés partiraient.

Prodoscore prévoit de lancer prochainement un indice de bonheur/bien-être distinct qui exploitera les discussions d’équipe et d’autres communications dans le but de découvrir comment les travailleurs se sentent. Il serait, par exemple, en mesure de prévenir un employé mécontent qui pourrait avoir besoin d’une pause, affirme Naficy.

Mais que pensent les travailleurs eux-mêmes d’être ainsi surveillés ?

James et le reste de son équipe chez le détaillant américain ont appris qu’à leur insu, l’entreprise surveillait leurs frappes dans la base de données.

Au moment où il était réprimandé, James s’est rendu compte que certaines des lacunes seraient en fait des pauses dont les employés avaient besoin pour manger. Plus tard, il réfléchit longuement à ce qui s’était passé. Bien que le suivi subreptice de ses frappes au clavier soit certainement inquiétant, ce n’était pas ce qui était vraiment intelligent. Ce qui était plutôt exaspérant, écrasant l’âme et un coup de pied dans les dents, c’était que les supérieurs n’avaient pas compris que la saisie de données n’était qu’une petite partie de son travail, et était donc une mauvaise mesure de ses performances. Communiquer avec les vendeurs et les coursiers consommait en fait la majeure partie de son temps.

C’était le manque de surveillance humaine, dit-il. C’est que vos chiffres ne correspondent pas à ce que nous voulons, malgré le fait que vous ayez prouvé que vos performances sont bonnes. Ils ont regardé les analystes individuels presque comme si nous étions des robots.

Pour les critiques, c’est en effet un paysage consternant. Beaucoup de ces technologies n’ont en grande partie pas été testées, explique Lisa Kresge, associée de recherche et de politique à l’Université de Californie, Berkeley Labour Center et co-auteur du récent rapport Data and Algorithms at Work.

Les scores de productivité donnent l’impression qu’ils sont objectifs et impartiaux et qu’on peut leur faire confiance car ils sont dérivés de la technologie, mais le sont-ils ? Beaucoup utilisent l’activité comme indicateur de productivité, mais plus d’e-mails ou d’appels téléphoniques ne se traduisent pas nécessairement par une plus grande productivité ou de meilleures performances. Et la façon dont les systèmes propriétaires arrivent à leurs scores est souvent aussi peu claire pour les managers que pour les travailleurs, dit Kresge.

De plus, les systèmes qui classent automatiquement le temps d’un travailleur en temps d’inactivité et en temps productif portent des jugements de valeur sur ce qui est productif et ce qui ne l’est pas, note Merve Hickok, directrice de recherche au Center for AI and Digital Policy et fondatrice de AIethicist.org. Un travailleur qui prend le temps de former ou de coacher un collègue peut être classé comme improductif car il y a moins de trafic provenant de son ordinateur, dit-elle. Et les scores de productivité qui obligent les travailleurs à être compétitifs peuvent les amener à essayer de jouer avec le système plutôt que de faire un travail productif.

Les modèles d’IA, souvent formés sur des bases de données de comportements antérieurs de sujets, peuvent également être inexacts et créer des biais. Les problèmes de préjugés sexistes et raciaux ont été bien documentés dans la technologie de reconnaissance faciale. Et il y a des problèmes de confidentialité. Les produits de surveillance à distance qui impliquent une webcam peuvent être particulièrement problématiques : il pourrait y avoir un indice qu’une travailleuse est enceinte (un berceau en arrière-plan), d’une certaine orientation sexuelle ou vit avec une famille élargie. Cela donne aux employeurs un niveau d’information différent de ce qu’ils auraient autrement, dit Hickok.

Il y a aussi un bilan psychologique. Être surveillé diminue votre sentiment d’autonomie perçue, explique Nathanael Fast, professeur agrégé de gestion à l’Université de Californie du Sud qui codirige son Institut de psychologie de la technologie. Et cela peut augmenter le stress et l’anxiété. La recherche sur les travailleurs de l’industrie des centres d’appels, qui a été un pionnier de la surveillance électronique, met en évidence la relation directe entre la surveillance intensive et le stress.

Programmeur informatique et défenseur du travail à distance David Heinemeier Hansson a mené une campagne d’une entreprise contre les fournisseurs de la technologie. Au début de la pandémie, il a annoncé que la société qu’il a cofondée, Basecamp, qui fournit un logiciel de gestion de projet pour le travail à distance, interdirait aux fournisseurs de la technologie de s’y intégrer.

Les entreprises ont tenté de repousser, dit Hansson, très peu d’entre elles se considèrent comme des fournisseurs de technologie de surveillance, mais Basecamp ne pouvait pas être complice du soutien de la technologie qui a fait subir aux travailleurs un traitement aussi inhumain, dit-il. Hansson n’est pas assez naïf pour penser que sa position va changer les choses. Même si d’autres entreprises suivaient l’exemple de Basecamps, cela ne suffirait pas à étouffer le marché.

Selon Hansson et d’autres critiques, ce qui est vraiment nécessaire, ce sont de meilleures lois régissant la manière dont les employeurs peuvent utiliser des algorithmes et protéger la santé mentale des travailleurs. Aux États-Unis, à l’exception de quelques États qui ont introduit une législation, les employeurs ne sont même pas tenus de divulguer spécifiquement la surveillance aux travailleurs. (La situation est meilleure au Royaume-Uni et en Europe, où des droits généraux relatifs à la protection des données et à la vie privée existent, mais le système souffre d’un manque d’application.)

Hansson exhorte également les gestionnaires à réfléchir à leur désir de surveiller les travailleurs. Le suivi peut attraper ce goofer sur 100, dit-il. Mais qu’en est-il des 99 autres dont vous avez rendu l’environnement totalement insupportable ?

Quant à James, il cherche un autre emploi où les habitudes de surveillance toxiques ne font pas partie de la vie professionnelle.