Les routes vers Zettascale et l’informatique quantique sont longues et sinueuses

Aux États-Unis, la première étape sur la voie des systèmes HPC exascale a commencé par une série d’ateliers en 2007. Ce n’est qu’une décennie et demie plus tard que le système Frontier de 1 686 pétaflops du laboratoire national d’Oak Ridge a été mis en ligne. Cette année, le laboratoire national d’Argonne se prépare à activer l’interrupteur pour Aurora, qui sera la deuxième ou la troisième machine exascale de ce type aux États-Unis, selon le moment du système El Capitan au laboratoire national Lawrence Livermore.

Il y a eu des retards et des revers sur la voie de l’exascale pour toutes ces machines, ainsi que des changements technologiques, une concurrence continue avec la Chine et d’autres défis. Mais ne vous attendez pas à ce que le prochain saut vers l’échelle zetta ou même l’informatique quantique soit plus rapide, selon Rick Stevens, directeur associé du laboratoire d’informatique pour l’environnement et les sciences de la vie à Argonne. Les deux pourraient prendre encore 15 à 20 ans ou plus.

Telle est la nature du HPC.

Il s’agit d’un jeu à long terme, a déclaré Stevens dans un récent webinaire sur l’avenir proche et plus lointain de l’informatique dans le HPC. Si vous êtes intéressé par ce qui se passe l’année prochaine, HPC n’est pas le jeu pour vous. Si vous voulez penser en termes d’une décennie ou de deux décennies, HPC est le jeu qu’il vous faut, car vous étiez sur une trajectoire de mille ans pour vous rendre dans d’autres systèmes stellaires ou autre. Ce ne sont que les premiers jours. Oui, nous avons eu une excellente série de lois de Moores. L’humanité ne se termine pas demain. Nous avons un long chemin à parcourir, nous devons donc réfléchir à ce que signifie le calcul haute performance dans dix ans ? Qu’est-ce que cela signifie dans vingt ans ? Cela ne veut pas dire la même chose. En ce moment, ça va signifier quelque chose de différent.

Cette partie en ce moment qui était au cœur de la conférence de Stevens est l’IA. Non seulement les applications HPC et les domaines de recherche améliorés par l’IA qui bénéficieraient de la technologie, mais aussi les simulations et les substituts gérés par l’IA, les accélérateurs d’IA dédiés et le rôle que l’IA jouera dans le développement des grands systèmes. Il a noté l’explosion des événements dans le domaine de l’IA entre 2019 et 2022, l’essentiel du temps passé dans la pandémie de COVID-19.

Alors que les grands modèles de langage qui sont au cœur d’outils tels que le très populaire ChatGPT et d’autres chatbots d’IA génératifs et l’apprentissage en profondeur texte-image Stable Diffusion ont décollé, des techniques d’IA ont été utilisées pour replier un milliard de protéines et améliorer les problèmes mathématiques ouverts et , il y a eu une adoption massive de l’IA parmi les développeurs HPC. L’IA a été utilisée pour accélérer les applications HPC. En plus de tout cela, les systèmes exascale ont commencé à arriver.

Cette explosion se poursuit en termes de plus en plus de groupes construisant des modèles à grande échelle et presque tous ces modèles sont dans le secteur privé, a déclaré Stevens. Il n’y en a qu’une poignée qui sont même réalisées par des organisations à but non lucratif, et beaucoup d’entre elles sont des sources fermées, y compris GPT-4, qui est la meilleure actuellement disponible. Cela nous dit que la tendance n’est pas vers des millions de modèles minuscules, mais vers un nombre relativement restreint de modèles très puissants. C’est un type important de méta-chose qui se passe.

Toutes ces simulations et substituts, les applications d’IA émergentes et les cas d’utilisation de l’IA nécessiteront beaucoup plus de puissance de calcul dans les années à venir. L’Argonne Leadership Computing Facility (ALCF) dans l’Illinois commence à réfléchir à cela alors qu’il trace sa machine post-Aurora et celles au-delà. Stevens et ses associés envisagent un système huit fois plus puissant qu’Aurora, avec une demande de propositions à l’automne 2024 et une installation d’ici 2028 ou 2029. Il devrait être possible de construire des machines de faible précision pour l’apprentissage automatique qui sont approchant un demi-zettaflop pour les opérations de faible précision. Dans deux ou trois tours à partir de maintenant, a déclaré Stevens.

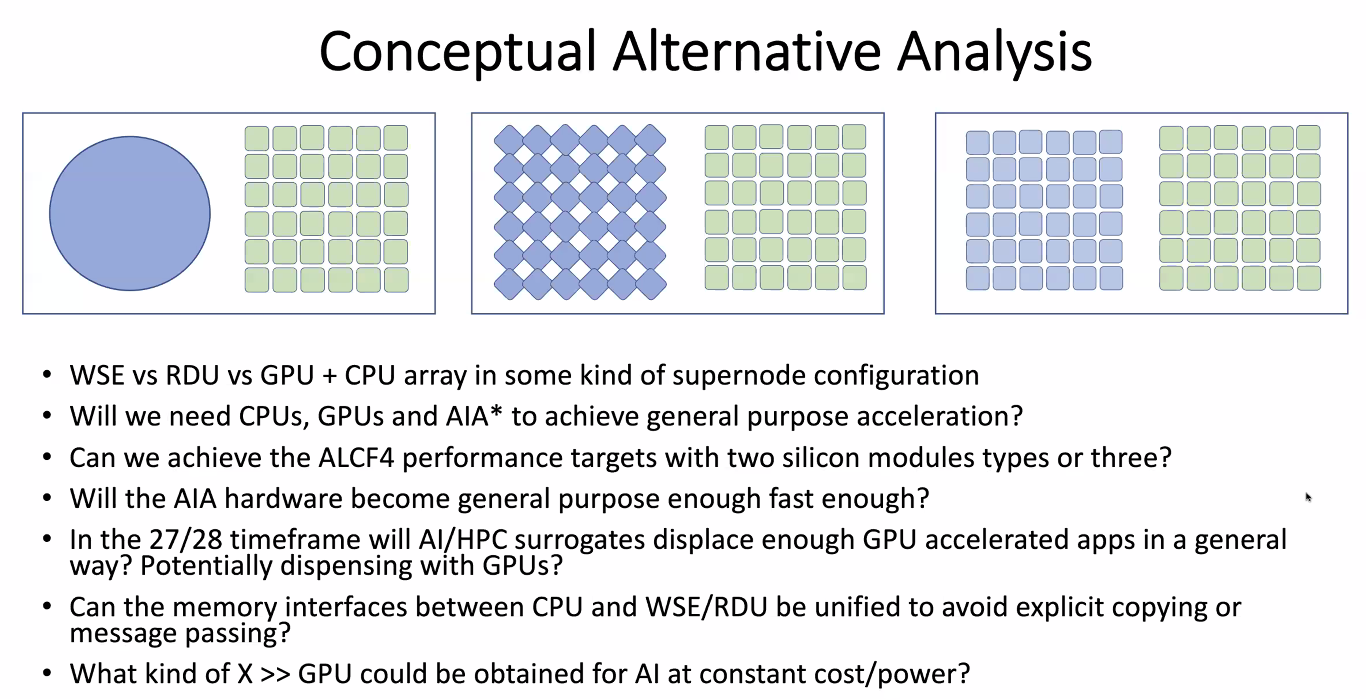

Une question portera sur les accélérateurs dans de tels systèmes. S’agira-t-il de versions plus récentes des GPU à usage général utilisés actuellement, de GPU augmentés de quelque chose de plus spécifique aux simulations d’IA ou d’un tout nouveau moteur optimisé pour l’IA ?

C’est la question fondamentale. Nous savons que la simulation va continuer à être importante et qu’il y aura un besoin pour une numérique haute performance et haute précision, mais quel est le rapport de cela par rapport à l’IA est la question ouverte, a-t-il déclaré. Les différents centres du monde entier qui réfléchissent à leur prochaine génération seront tous confrontés à un type de décision similaire quant à leur degré d’inclinaison vers le marché de l’IA ou la base d’applications de l’IA à l’avenir.

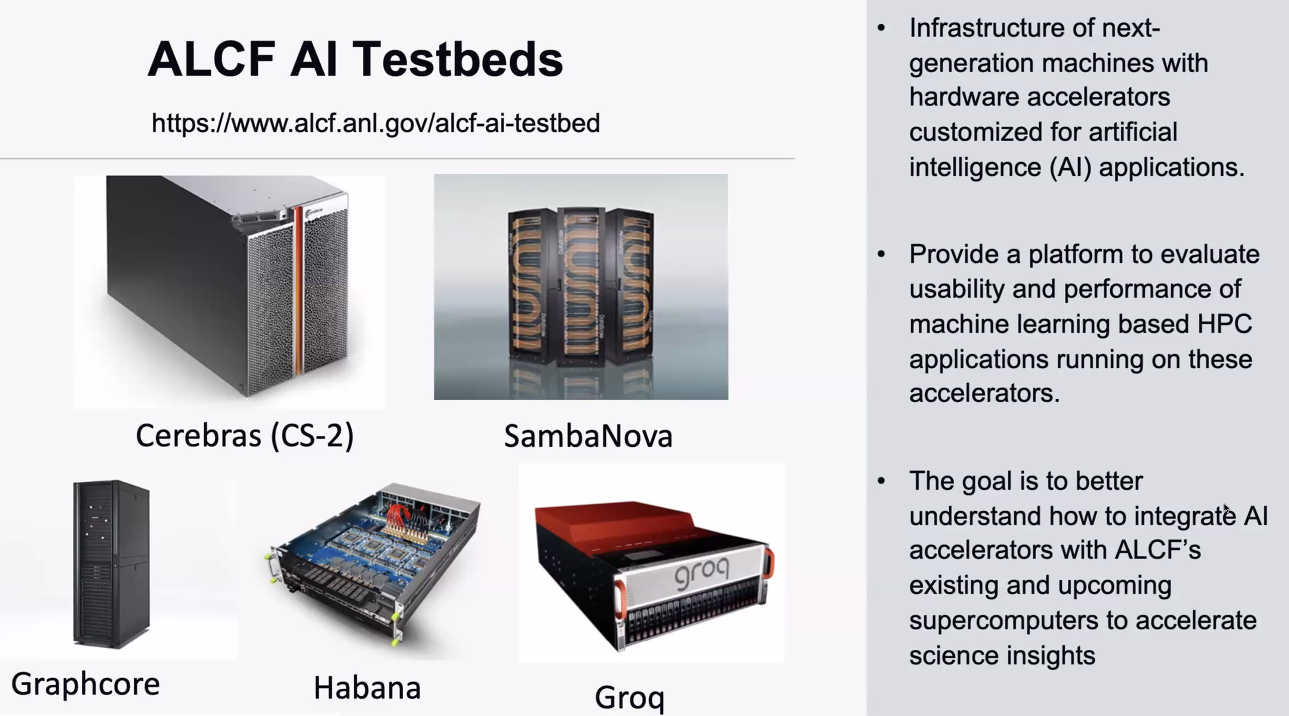

L’ALCF a construit des bancs d’essai d’IA, en utilisant des systèmes de Cerebras Systems, SambaNova Systems, GraphCore, la partie Habana Labs d’Intel et Groq, qui comprendront des accélérateurs conçus pour les charges de travail d’IA pour voir si ces technologies mûrissent assez rapidement pour qu’elles puissent être le base d’un système à grande échelle et exécuter efficacement l’application d’apprentissage automatique HPC.

La question est de savoir si les GPU à usage général vont être assez rapides dans ce scénario et suffisamment étroitement couplés aux CPU pour qu’ils soient toujours la bonne solution ou est-ce que quelque chose d’autre va émerger dans ce laps de temps ? a-t-il déclaré, ajoutant que la question du support multi-locataires sera essentielle. Si vous avez un moteur qui utilise un sous-ensemble du nœud, comment pouvez-vous prendre en charge certaines applications dans un sous-ensemble ? Comment pouvez-vous prendre en charge l’occupation multiple de ce nœud avec des applications qui complètent les ressources ? Il y a beaucoup de questions ouvertes sur la façon de procéder.

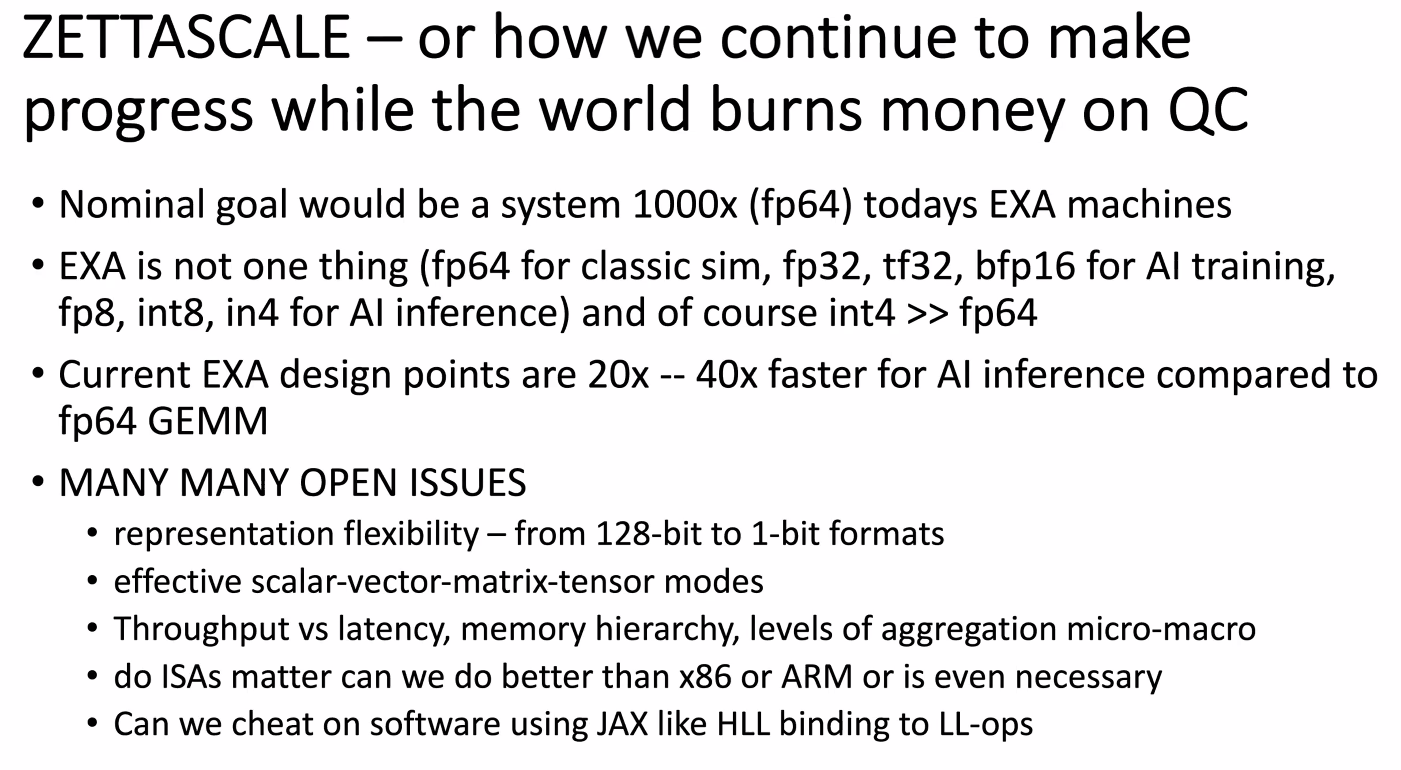

Certaines de ces questions sont décrites ci-dessous :

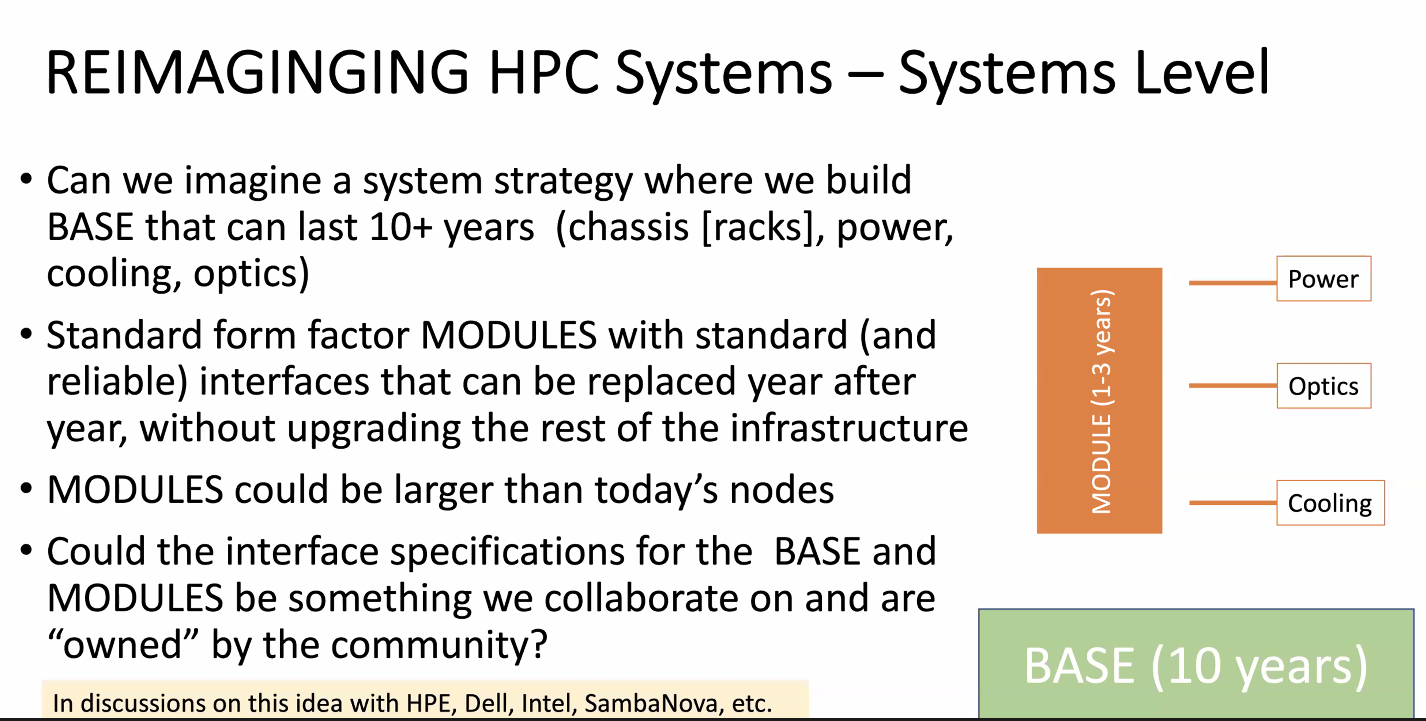

Il y a aussi la question de savoir comment ces nouveaux grands systèmes seront construits. En règle générale, les nouvelles vagues de technologie modifient les systèmes de refroidissement ou d’alimentation, par exemple, impliquent des mises à niveau majeures de l’ensemble de l’infrastructure. Stevens a déclaré que l’idée d’une conception plus modulaire où les composants sont commutés mais le système lui-même reste plus logique. Les modules des systèmes, qui peuvent être plus grands que les nœuds actuels, peuvent être remplacés régulièrement sans avoir à mettre à niveau l’ensemble de l’infrastructure.

Y a-t-il une base qui pourrait avoir une infrastructure d’alimentation, de refroidissement et peut-être d’optique passive, puis des modules qui doivent être remplacés beaucoup plus fréquemment alignés avec des nœuds de fabrication qui ont des interfaces vraiment simples ? il a dit. Ils ont un connecteur d’alimentation, ils ont un connecteur optique et ils ont un connecteur de refroidissement. C’est quelque chose auquel nous avons pensé et dont nous avons parlé avec les fournisseurs : comment l’emballage pourrait évoluer pour le rendre beaucoup plus modulaire et nous faciliter la mise à niveau des composants du système sur une période de deux ans au lieu de cinq ans. délai de l’année.

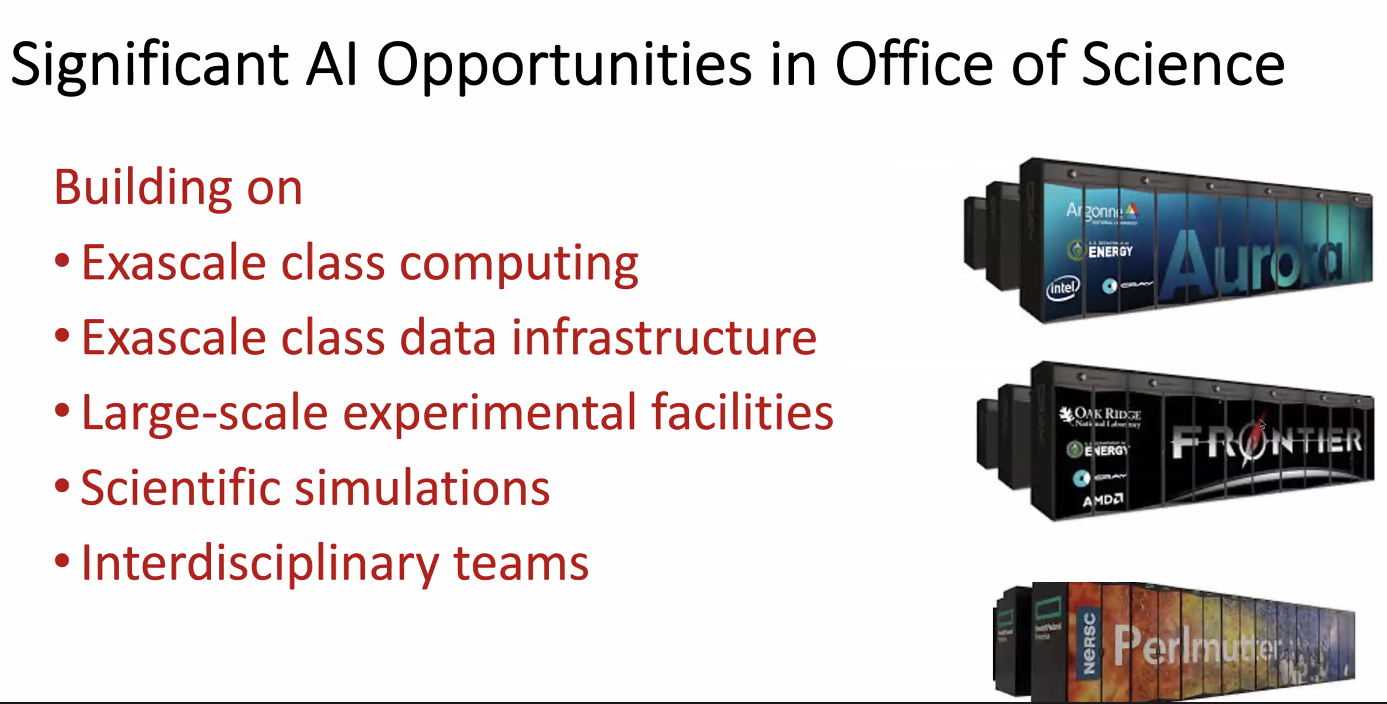

L’ALCF examine ces problèmes de manière plus agressive qu’au cours des dernières années, compte tenu des actifs que détient le Bureau des sciences du Département de l’énergie, tels que l’infrastructure de calcul et de données exascale, les installations expérimentales à grande échelle et une large base de code pour les simulations scientifiques. . Il y a aussi beaucoup d’équipes interdisciplinaires à travers les domaines et les laboratoires ; le projet Exascale Compute comprenait 1 000 personnes travaillant ensemble, selon Stevens.

L’automatisation est un autre facteur. Argonne et d’autres laboratoires ont toutes ces grosses machines et un grand nombre d’applications, a-t-il déclaré. Peuvent-ils trouver des moyens d’automatiser une grande partie du travail, comme la création et la gestion d’un substitut d’IA pour rendre le processus plus rapide, plus facile et plus efficace ? C’est un autre domaine de recherche qui est en cours.

Pendant que tout ce travail se poursuit, le développement de systèmes à l’échelle zettascale et quantique évolue à leur propre rythme, que Stevens ne s’attend pas à voir largement utilisés avant 15 à 20 ans. D’ici la fin de la décennie, il sera possible de construire une machine à l’échelle zetta avec une faible précision, mais l’utilité d’un tel système variera. Finalement, il sera possible de construire une telle machine à 64 bits, mais ce n’est probablement pas avant au moins 2035. (Pas le 2027 auquel Intel parlait La prochaine plateforme environ en octobre 2021.)

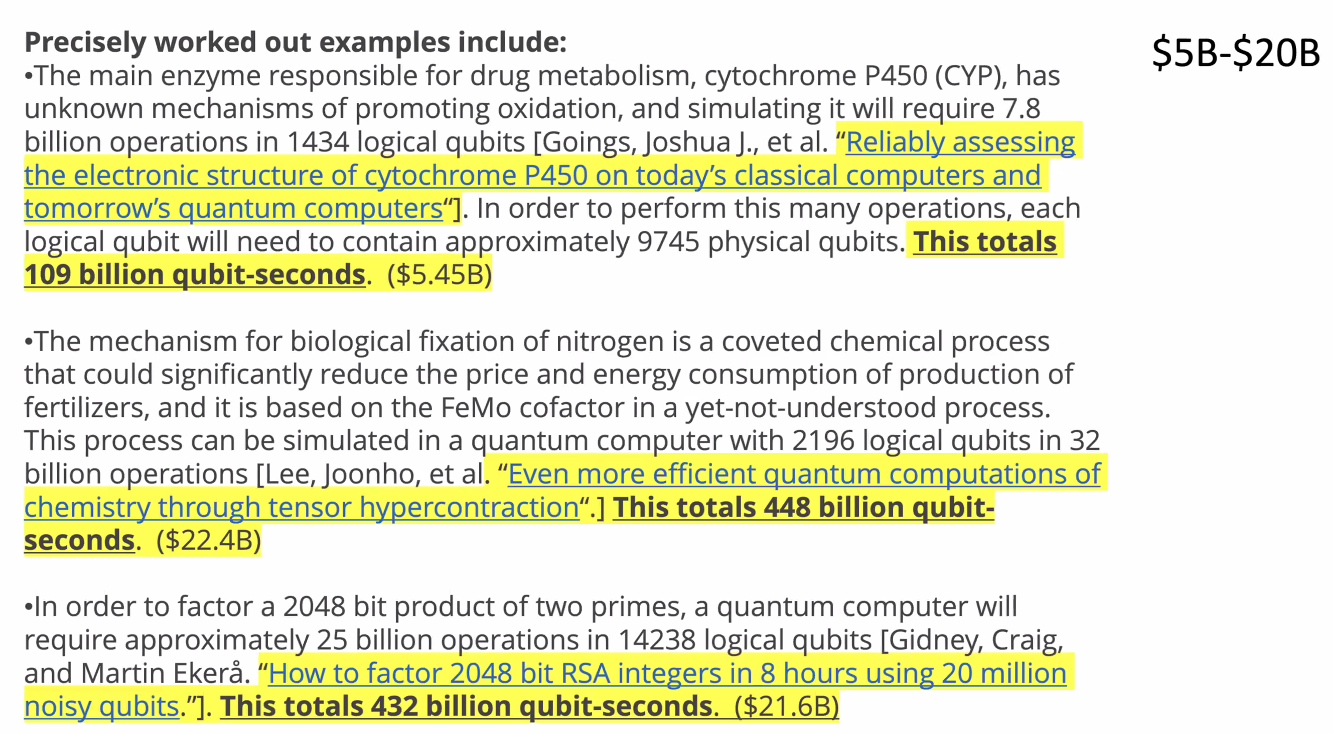

Pour le quantique, les coûts impliqués seront aussi importants que la technologie. Deux semaines d’exécution d’une application sur une machine exascale coûtent environ 7 millions de dollars en temps de calcul. Sur une machine quantique à grande échelle avec jusqu’à 10 millions de qubits qui n’existent pas encore, un problème pourrait coûter entre 5 et 20 milliards de dollars, comme indiqué ci-dessous. Ce coût devrait descendre en ordres de grandeur pour qu’il puisse valoir ce que les gens paieraient pour résoudre des problèmes à grande échelle.

Ce que cela nous dit, c’est que nous devons continuer à progresser sur l’informatique classique pendant que le quantique se développe, car nous pouvons savoir que nous pouvons utiliser l’informatique classique pour résoudre de vrais problèmes, a-t-il déclaré. C’est vraiment un peu un argument pour cela. Nous pensons que les progrès à l’échelle zetta vont également prendre 15 à 20 ans, mais c’est un délai dans lequel nous étions assez confiants et nous savons que nous pouvons réellement utiliser ces machines.

Tout cela revient au thème initial : l’innovation dans le HPC prend beaucoup de temps. Les systèmes hybrides quantiques-classiques pourraient éventuellement être la voie à suivre. L’industrie devra peut-être remplacer les substrats de calcul par quelque chose de moléculaire, d’optique ou qui n’a pas encore été inventé. Les ingénieurs, les scientifiques et les autres auront besoin de beaucoup de choses.

La chose qui change le paysage le plus rapidement en ce moment est l’IA et nous avons à peine effleuré la façon dont nous pourrions réorganiser les systèmes pour qu’ils soient vraiment la plate-forme idéale pour effectuer des calculs d’IA à grande échelle, a déclaré Stevens. Cela pourrait tellement changer la donne que si nous avions cette conversation dans 10 ans, peut-être que quelque chose d’autre se serait produit. Ou peut-être étaient-ils en plein dans le mille. Je suppose que ce sera quelque part au milieu. Ça va être un long match et il y aura de nombreuses perturbations et la chose avec laquelle nous devons nous sentir à l’aise est de trouver comment naviguer dans les perturbations, pas comment combattre les perturbations, car les perturbations sont nos amies. Ce sont en fait ce qui va nous donner de nouvelles capacités et nous devons les rechercher de manière agressive.